The post Entwicklungspraxis, Sensorik und Bewertung von Delphi Mobile appeared first on Entwickler Konferenz.

]]>Alternativen und Optionen

Es gibt folgende Alternativen zur vorgestellten Konfiguration:

-

RAD Studio kann unmittelbar auf einem Windows-PC, d. h. ohne Virtualisierung ausgeführt werden. Der Zugriff auf einen iOS-Simulator kann dann über das lokale Netzwerk erfolgen. Ein Android-Emulator kann auf dem Windows-PC ausgeführt werden (x64-Architektur, langsam).

-

Hilfsweise kann statt eines physischen Macs auch ein Cloud-Service genutzt werden. Auf diesem können dann Xcode und der Simulator installiert werden. Ein geeigneter Service ist beispielsweise [5]. Auf diesen Cloud-Computer wird in diesem Fall via Remote-Desktop zugegriffen. Ein physisches iPhone kann dann jedoch nicht zum Testen genutzt werden.

In jedem Fall gilt: Ab einem gewissen Fortschritt in der Entwicklung der Mobile-App muss diese regelmäßig auf physischen Geräten, d. h. Android-Smartphones und iPhones, getestet werden. Einige Features, wie beispielsweise die Sensibilität von Sensoren, lassen sich nur bedingt mit Hilfe von Emulation bzw. Simulation prüfen. Im Idealfall stehen in einem professionellen Entwickler-Set-up zum Testen mehrere Geräte mit unterschiedlicher Hard- und Softwareausstattung (Betriebssystemversionen) zur Verfügung.

Hinweis (bzw. eine ganz persönliche Anmerkung): Bitte lassen Sie sich bei der Konfiguration nicht frustrieren. Die Einrichtung der Developer-Pipeline für die Mobile-Entwicklung (Android, iOS) ist nicht trivial. Versionen und Tools müssen zueinander passen und die richtigen Befehle müssen auf der Kommandozeile eingegeben werden. Wenn man sich mit Konsole und Netzwerk nicht auskennt, ist es eine Herausforderung und es ist ganz normal, dass man einiges ausprobieren muss. Der Autor hat die Schritte zusammengestellt, um Android und iOS aus RAD Studio auf einer Maschine nutzbar zu machen. Das liest sich im Ergebnis einfach und logisch, doch der Weg bis zur Erkenntnis war bedeutend länger.

Mobile-Apps mit Delphi – Projektstart

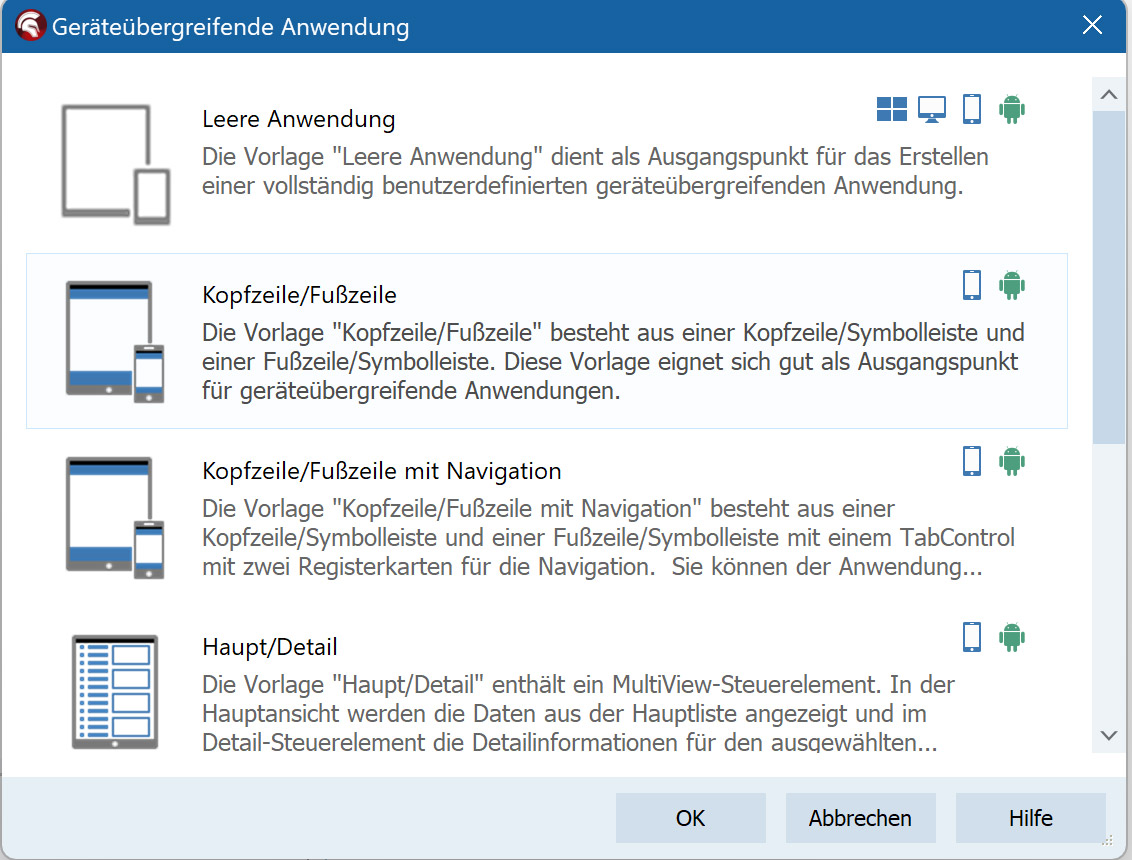

Eine Mobile-Delphi-Anwendung startet man in der IDE typischerweise über Datei | Neu | Multi-Device-Anwendung (Abb. 9).

Es stehen verschiedene Projektvorlagen bereit (z. B. leere Anwendung oder Tabbed Template), die bereits eine Grundstruktur für Android und iOS enthalten. Die Projektgruppe enthält von Anfang an Einträge für beide Zielplattformen, und im Projektmanager kann man zwischen Android und iOS Device 64-bit (bzw. iOS Simulator, falls ein Apple Silicon Mac verfügbar ist) umschalten. Praktisch gesehen unterscheidet sich die Projektanlage kaum von einer VCL-Anwendung – abgesehen von der Auswahl eines FireMonkey-Projekts. Delphi legt eine Unit mit einer Formularklasse (einer Ableitung von TForm) an, die für Mobile-Apps üblicherweise zunächst die Namen Unit1.pas/Form1.fmx trägt. Darin befindet sich der gemeinsame Quelltext für beide Plattformen. Plattformspezifische Anpassungen kann man über Compilerdirektiven vornehmen (z. B. mit {IFDEF ANDROID} / {IFDEF IOS}). Soll beispielsweise unter iOS ein abweichender Programmablauf erfolgen, lässt sich das zur Not mit solchen Direktiven im Code lösen. Doch in vielen Fällen ist das gar nicht notwendig. Im Idealfall bleibt die Codebasis vollständig plattformneutral.

RAD Studio bietet viele abstrakte Klassen und Services, die Android und iOS vereinheitlichen – vom Dateisystemzugriff über HTTP-Anfragen bis hin zu Threading oder GUI-Komponenten. So kann man den Großteil der App-Logik ohne besondere Berücksichtigung des Ziel-OS entwickeln. Erst bei wirklich systemspezifischen Funktionen kommt man an einen Punkt, an dem man gezielt Code für eine Plattform schreiben muss.

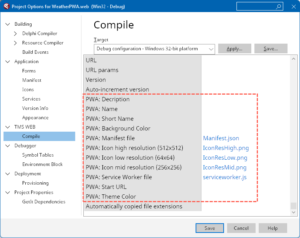

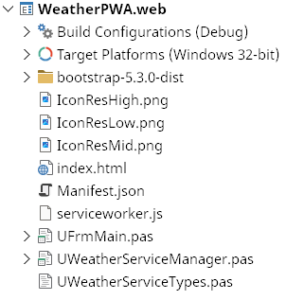

Bevor die App erstmals gestartet wird, müssen einige Projekteinstellungen überprüft werden. Im Options-Dialog des Projekts wird der Application Identifier (Bundle-ID) festgelegt und es werden gegebenenfalls die benötigten Berechtigungen hinterlegt. So müssen für die Nutzung des Gerätestandorts (GPS) beispielsweise in Android die entsprechenden Berechtigungen (ACCESS_FINE_LOCATION etc.) aktiviert werden, damit Delphi sie in die Android-Manifest-Datei einträgt. Unter iOS wiederum muss sichergestellt werden, dass in der Datei Info.plist ein Eintrag für NSLocationWhenInUseUsageDescription vorhanden ist. Das kann ebenfalls über die Delphi-Projekteinstellungen konfiguriert werden. RAD Studio kümmert sich dann um die richtige Einbindung dieser Parameter ins Deployment. Für viele Standardfälle bringt Delphi bereits sinnvolle Voreinstellungen mit. Beispielsweise werden bei Verwendung der TCameraComponent automatisch die Kameraberechtigungen angefordert. Entwickler:innen behalten dennoch die Flexibilität, diese Einstellungen an ihre eigenen Erfordernisse anzupassen.

UI-Design mit FireMonkey

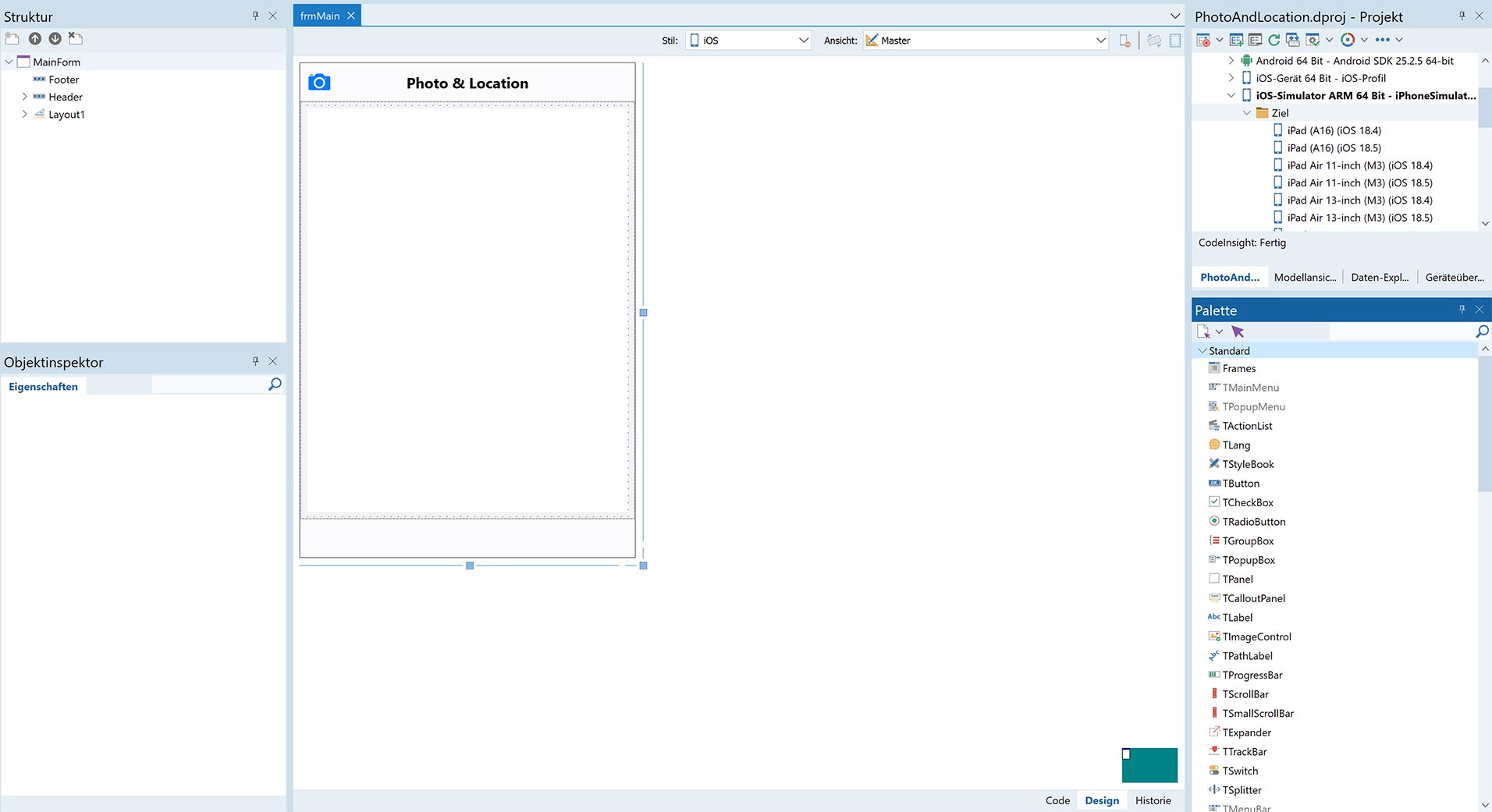

Die Benutzeroberfläche wird mit dem FireMonkey-Framework gestaltet, das einen grafischen Multi-Device-Designer (Abb. 10) bereitstellt.

Alle visuellen Komponenten, beispielsweise Buttons, Listen oder Eingabefelder, werden per Drag and Drop auf das Formular gezogen und dort ausgerichtet. Der Clou dabei ist, dass dieses eine Formular als Master-Form für alle Geräte dient. Das UI wird also einmal entworfen – und anschließend werden die gerätespezifischen Verfeinerungen vorgenommen, ohne dass der Code aufgespalten werden muss. Dabei erlaubt Delphi, sogenannte View-Varianten für unterschiedliche Auflösungen oder Formfaktoren anzulegen. So kann man beispielsweise eine spezielle iPhone-Ansicht definieren, in der bestimmte Elemente speziell angeordnet oder skaliert sind. Diese Varianten erben sämtliche Elemente und Logik von der Master-Form, lassen sich aber im Layout getrennt anpassen. In der Praxis bedeutet das: Ein Großteil des UI-Designs wird plattformübergreifend entworfen und nur dort nachjustiert, wo es nötig ist, beispielsweise bei größeren Bildschirmen, einem anderen Seitenverhältnis oder der Ausrichtung im Hoch- oder Querformat. Delphi bietet darüber hinaus eine Multi-Device-Vorschau an. Im Designer kann man sich das Formular parallel auf verschiedenen Gerätedummies anzeigen lassen, z. B. als iPhone 14 und als Android-Tablet. Das ist sehr hilfreich, um das responsive Design der Oberfläche früh zu überprüfen.

FireMonkey selbst setzt auf hardwarebeschleunigtes Rendering. Anders als die VCL (die auf nativen Windows-Controls basiert) zeichnet FMX sämtliche Steuerelemente selbst – plattformunabhängig und mittels GPU. Dadurch sind flüssige Animationen und aufwendige Grafikeffekte möglich, die von der Grafikkarte des Geräts profitieren. Standard-Controls wie Buttons oder Listboxen folgen dem Style-Prinzip, d. h. sie werden durch Style-Vorlagen dem jeweiligen Betriebssystem optisch nachempfunden. FMX bringt für Android und iOS eigene Style-Sets mit, sodass z. B. ein TSwitch-Schalter unter iOS wie ein nativer iOS-Umschalter aussieht. Über den Behavior Service passen sich zudem gewisse Verhaltensweisen automatisch an. So werden Tabs auf iOS am unteren Bildschirmrand, auf Android hingegen oben angezeigt.

Entwickler:innen können das Look and Feel auch vollständig selbst gestalten: Über den FMX Style Designer oder durch Zuweisung von alternativen Styles (Dark/Light Theme etc.) erhält man volle Kontrolle über die Optik. Auch plattformnative Controls lassen sich in FireMonkey einbinden.

Moderne FireMonkey-Oberflächen sind durch die GPU-Nutzung in der Regel sehr performant, allerdings erkauft durch einen initialen Overhead beim App-Start. Das Starten einer FMX-App dauert erfahrungsgemäß etwas länger als das Starten einer minimalistischen nativen App, da zunächst die FMX-Bibliothek geladen werden muss. In der Praxis bewegt sich das auf aktuellen Geräten jedoch im Rahmen von ein bis zwei Sekunden. Die Laufzeitperformance der Anwendung, beispielsweise beim Scrollen durch Listen, dem Öffnen von Formularen oder dem Durchführen von Berechnungen ist dagegen nahezu identisch mit der von nativen Apps, da der übersetzte Maschinencode ohne Zwischenschicht auf der CPU läuft. Durch die statische Verlinkung aller benötigten Bibliotheken liegt die App-Größe meist etwas über der von vergleichbaren nativen Apps. Angesichts heutiger Gerätespeicher ist das jedoch selten ein Problem. Insgesamt lässt sich festhalten, dass FireMonkey-UIs bei korrekter Verwendung hinreichend performant sind und den Nutzer:innen ein zeitgemäßes Nutzungserlebnis bieten.

Nutzung von Gerätesensoren

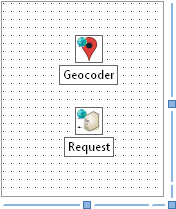

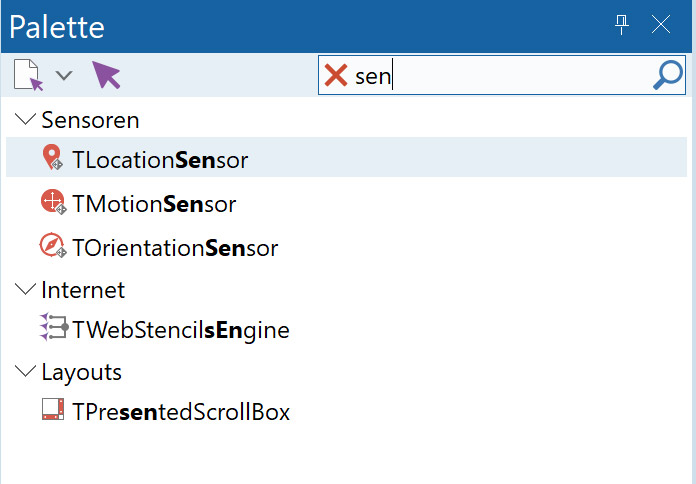

Eine Stärke von Delphi für Mobile ist der einfache Zugriff auf Gerätesensoren. Die RTL (Run Time Library) umfasst dafür vordefinierten Komponenten und Klassen, die die Sensorhardware abstrahieren. So gibt es beispielsweise eine Komponente TLocationSensor, die GPS-Geodaten liefert, einen TMotionSensor (für Beschleunigungssensor/Gyroskop), einen TOrientationSensor (Lagesensor/Kompass) sowie die TCameraComponent für den Zugriff auf die Kamera (Abb. 11).

Diese nicht visuellen Komponenten werden bei Bedarf auf das Formular gezogen. Anschließend kann dann über Ereignisse und Methoden auf die Sensordaten zugegriffen werden. Ein Beispiel: Durch Setzen von LocationSensor.Active := True startet die Standorterfassung. Über das Ereignis OnLocationChanged liefert die Komponente anschließend die aktuellen Breiten- und Längengrade, auf die im Code reagiert werden kann, beispielsweise um die Position auf einer Karte anzuzeigen.

Delphi kapselt hierbei die Unterschiede der Plattformen. Ob die Positionsdaten nun vom iOS-Dienst oder vom Android-Location-Provider stammen, braucht Entwickler:innen nicht zu kümmern. Ähnlich funktioniert TMotionSensor für Beschleunigungs- und Rotationsdaten, die beispielsweise zur Erkennung von Bewegungen oder zur Steuerung eines Spiels genutzt werden können. Auch auf die Gerätekamera kann mit wenig Aufwand zugegriffen werden. Die einfachste Methode stellt die Action TTakePhotoFromCameraAction dar: Platziert man diese Aktion und verknüpft sie mit einem Button, öffnet ein Tipp darauf direkt die native Kamera-App des Geräts, erlaubt das Aufnehmen eines Fotos und liefert das Bild anschließend zurück in die Delphi-Anwendung. Will man mehr Kontrolle, verwendet man die TCameraComponent. Diese bietet Funktionen, um die Kamera direkt im eigenen App-Fenster zu aktivieren, Fotos oder Videos aufzunehmen und z. B. zwischen Front- und Rückkamera umzuschalten. Einstellungen wie Auflösung oder Fokusmodus können ebenfalls gesetzt werden. So lassen sich umfangreiche Kamerafunktionen bis hin zu QR-Code-Scannern oder AR-Anwendungen realisieren, wobei für spezialisierte Anforderungen ggf. ein plattformspezifischer API-Aufruf nötig ist.

Neben GPS, Bewegungssensoren und Kamera unterstützt Delphi zahlreiche weitere Hardwarefeatures. Erwähnenswert ist die Bluetooth/BLE-Unterstützung: In RAD Studio gibt es also Komponenten sowohl für klassisches Bluetooth als auch für Bluetooth Low Energy.

Ein Aspekt, den es bei der Nutzung von Sensoren zu beachten gilt, sind die Berechtigungen. Wie zuvor erwähnt, müssen bestimmte Berechtigungen deklariert werden, wenn sie benötigt werden. Darüber hinaus erfordern neuere Android- und iOS-Versionen oft auch eine Bestätigung durch den Nutzer zur Laufzeit (Runtime Permission). Delphi stellt Hilfsfunktionen bereit, um diese Berechtigungen zur Laufzeit abzufragen und zu verarbeiten. Entwickler:innen sollten also beim ersten Zugriff auf Kamera, Mikrofon, Standort etc. überprüfen, ob die App bereits die entsprechende Freigabe hat. Falls dies nicht der Fall ist, sollte eine Anfrage an den User gestellt werden. Dies lässt sich mit wenigen Codezeilen umsetzen und entspricht dem Vorgehen in anderen Entwicklungsumgebungen.

Einbindung von System-APIs

Trotz des breiten Spektrums an vorkonfektionierten Komponenten kommt es in der Mobile-Entwicklung gelegentlich vor, dass eine sehr spezifische Plattformfunktion benötigt wird, sei es eine besondere Apple- oder Google-API, die (noch) nicht Teil von FireMonkey oder einer Drittanbieter-Bibliothek ist. Ein großer Vorteil von Delphi ist, dass man in solchen Fällen direkt auf die nativen APIs der Zielplattform zugreifen kann. Delphi bietet zu diesem Zweck sogenannte Bridge Units und Header-Übersetzungen an. Für iOS existieren in Delphi beispielsweise Namespaces wie iOSapi.Foundation oder iOSapi.UIKit, die die Objective-C-Klassen und -Funktionen des Apple SDK verfügbar machen. Darüber lassen sich beliebige iOS-Frameworks ansprechen, als würde man in Swift oder Objective-C programmieren.

Ein Beispiel: Möchte man Touch ID bzw. Face ID nutzen, kann man die entsprechenden Routinen aus Apples LocalAuthentication-Framework über Delphi aufrufen, entweder indem man die mitgelieferten Header-Übersetzungen verwendet oder indem man bei neueren APIs selbst Interfacedefinitionen schreibt. Ähnlich verhält es sich bei Android: Hierfür stellt Embarcadero den Java2OP-Converter bereit, der Java-Bibliotheken in Delphi-Code (Interfaceklassen) umwandelt. So kann man beispielsweise eine spezielle Android-SDK-Funktion nutzen, die nicht im FMX-Standardumfang enthalten ist, indem man die Java-Methode nach Delphi importiert. Delphi kompiliert im Hintergrund die entsprechenden JNI-Aufrufe, sodass die App zur Laufzeit die Android-JVM nutzen kann, um diese Funktionen auszuführen. Dieser Weg, direkt mit nativen APIs zu arbeiten, erfordert zwar etwas zusätzlichen Aufwand, gewährleistet aber, dass keine Funktionalität der Plattform unerreichbar bleibt.

In der Praxis gibt es dafür auch Communityunterstützung: Es stehen einige Open-Source-Projekte und Bibliotheken zur Verfügung, die gängige Mobile-Dienste kapseln und erweiterte System-APIs für Delphi bereitstellen.

Geeignete Use Cases und Grenzen

Es zeigt sich, dass Delphi (RAD Studio) im Jahr 2025 ein ausgereiftes Ökosystem für die Mobile-Entwicklung bietet. Die Stärken liegen vor allem in der Produktivität: schnelles visuelles Entwickeln, Wiederverwendung von Code und Komponenten sowie eine Codebasis für alle Plattformen. Diese Vorteile kommen insbesondere in folgenden Anwendungsfällen zum Tragen:

-

Business- und Enterprise-Apps: Delphi eignet sich hervorragend, um datenbankgetriebene Anwendungen oder Unternehmenssoftware für mobile Endgeräte bereitzustellen. Bestehende Delphi-/VCL-Kenntnisse und -Code (z. B. Datenmodule mit FireDAC oder Logik aus einer Windows-Anwendung) lassen sich wiederverwenden, um eine passende Mobile-App als Ergänzung zu entwickeln. Wenn eine Firma bereits über eine umfangreiche Delphi-Codebasis verfügt, ist der Schritt zu Android-/iOS-Apps effizient umzusetzen.

-

Cross-Plattform-Projekte mit knapper Timeline: Wenn man „schnell“ eine App für Android und iOS gleichzeitig benötigt, ermöglichen die RAD-Prinzipien von Delphi ein rasches Vorgehen. Mit einem kleinen Team erreicht man Ergebnisse, für die man nativ eventuell zwei Teams bräuchte. Gerade Prototypen für Start-ups oder Pilotprojekte können so in kurzer Zeit umgesetzt werden, ohne dass man sich von Beginn an auf eine Plattform festlegen muss.

-

Industrie und spezialisierte Hardware: In Fällen, in denen Geräte mit besonderer Hardware angesteuert werden, etwa Barcodescanner, Messgeräte oder Spezialsensoren auf Android-Geräten, fällt Delphis Nähe zur Hardware besonders ins Gewicht. Man kann native Bibliotheken der Hardwarehersteller einbinden und hat volle Kontrolle über serielle Schnittstellen, Bluetooth-Protokolle usw. – und das alles in Delphi, ohne auf C++ oder Java wechseln zu müssen.

-

Multi-Platform-Desktop-Mobile-Kombinationsprojekte: Wenn eine Anwendung nicht nur auf Mobile-Geräten, sondern auch auf Windows-, macOS- und Linux-Desktops laufen soll, bietet Delphi den Vorteil, dass FireMonkey auch Desktopplattformen bedienen kann. Weite Teile der Codebasis können für Desktop und Mobile gemeinsam genutzt werden, es müssen nur das UI und Details angepasst werden. Diese „Write once, compile everywhere“-Fähigkeit ist ein Leistungsmerkmal.

Selbstverständlich gibt es auch Grenzen und Szenarien, in denen Delphi weniger geeignet ist. Grafikintensive Spiele etwa werden meist in spezialisierten Engines (Unreal, Unity etc.) entwickelt. Zwar unterstützt Delphi 2D-/3D-Grafik mit FMX, die Developer-Community in diesem Bereich ist jedoch kleiner. Anwendungen, die zu 100 Prozent an die nativen UI-Richtlinien einer Plattform angepasst sein müssen, können mit Delphi zwar umgesetzt werden, erfordern aber mitunter zusätzlichen Feinschliff beim Styling, damit sie pixelgenau wie eine typische iOS- oder Android-App aussehen. Wenn das oberste Ziel darin besteht, dass niemand einen Unterschied zu den Apple Human Interface Guidelines oder zum Material Design erkennen kann, muss man in der Delphi-Entwicklung bewusst mit Styles und gegebenenfalls mit nativen Controls arbeiten.

Ein weiterer Punkt sind externe Frameworks und Ökosystemabhängigkeiten. Für Android und iOS existiert eine Fülle an Open-Source-Bibliotheken, deren Direktverwendung in Delphi jedoch nicht immer trivial ist. Zwar lassen sich nichtvisuelle Bibliotheken meist problemlos einbinden, doch bei komplexen UI-Komponenten oder plattformspezifischen Cloud-SDKs kann die Integration aufwendiger werden.

Auch das Tooling rund um die App (Build-Pipelines, CI/CD, UI-Testautomation) ist für Delphi weniger standardisiert verfügbar als für Xcode bzw. Android Studio. Eine Rolle spielen dabei nicht zuletzt der Kostenfaktor und die strategische Ausrichtung: RAD Studio ist ein kommerzielles Produkt und auf dem Markt gibt es weniger Entwickler:innen für Delphi Mobile als für die großen Plattformsprachen. Für lange Projektlaufzeiten und sehr große Teams kann das ein Kriterium sein.

Praxisbeispiel

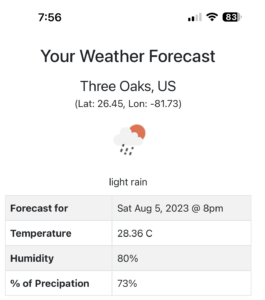

Nun zeigen wir, wie eine Mobile-App mit Delphi und FireMonkey entwickelt werden kann. Am Beispiel wird praxisnah demonstriert, wie die typischen Anforderungen einer Mobile-App – Zugriff auf Kamera, Sensoren, lokale Datenhaltung und UI-Darstellung – mit Delphi umgesetzt werden können. Die App soll die folgenden Kernfunktionen bereitstellen:

-

Fotoaufnahme direkt über die integrierte Kamera oder das System-Kamera-Interface,

-

Geodatenerfassung zum Zeitpunkt der Aufnahme,

-

Zusatznotizen pro Bild zur kontextuellen Dokumentation,

-

Speicherung der Metadaten lokal auf dem mobilen Device,

-

Galerieansicht, in der alle Fotos mit Miniaturansicht, Aufnahmezeit und Standortinformationen gelistet werden,

-

ggf. Detailansicht und Teilen-Funktion, um Bilder samt Metadaten über die native Share-Sheet-Funktion des Betriebssystems weiterzugeben.

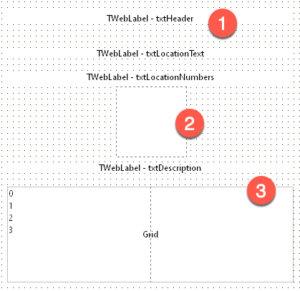

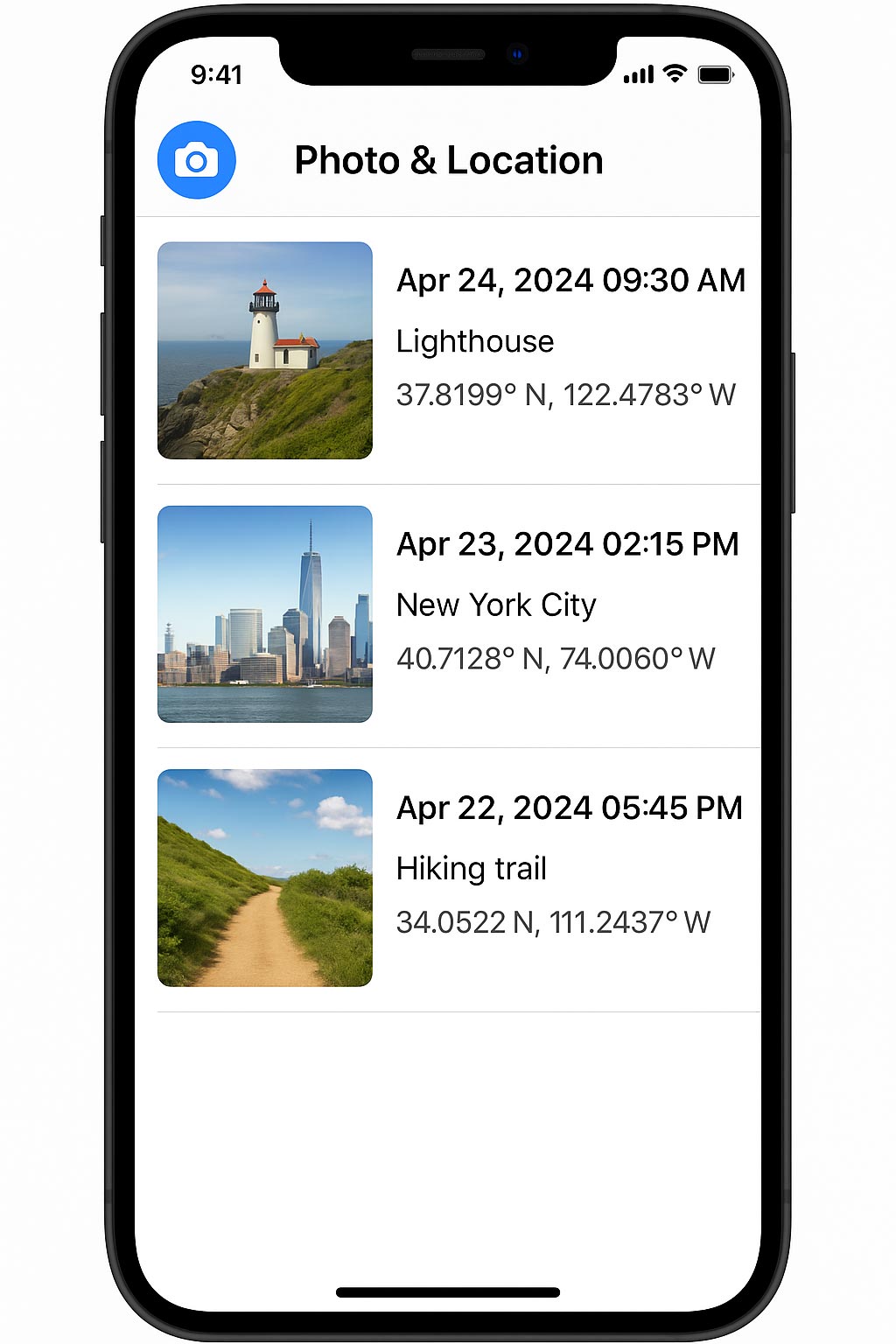

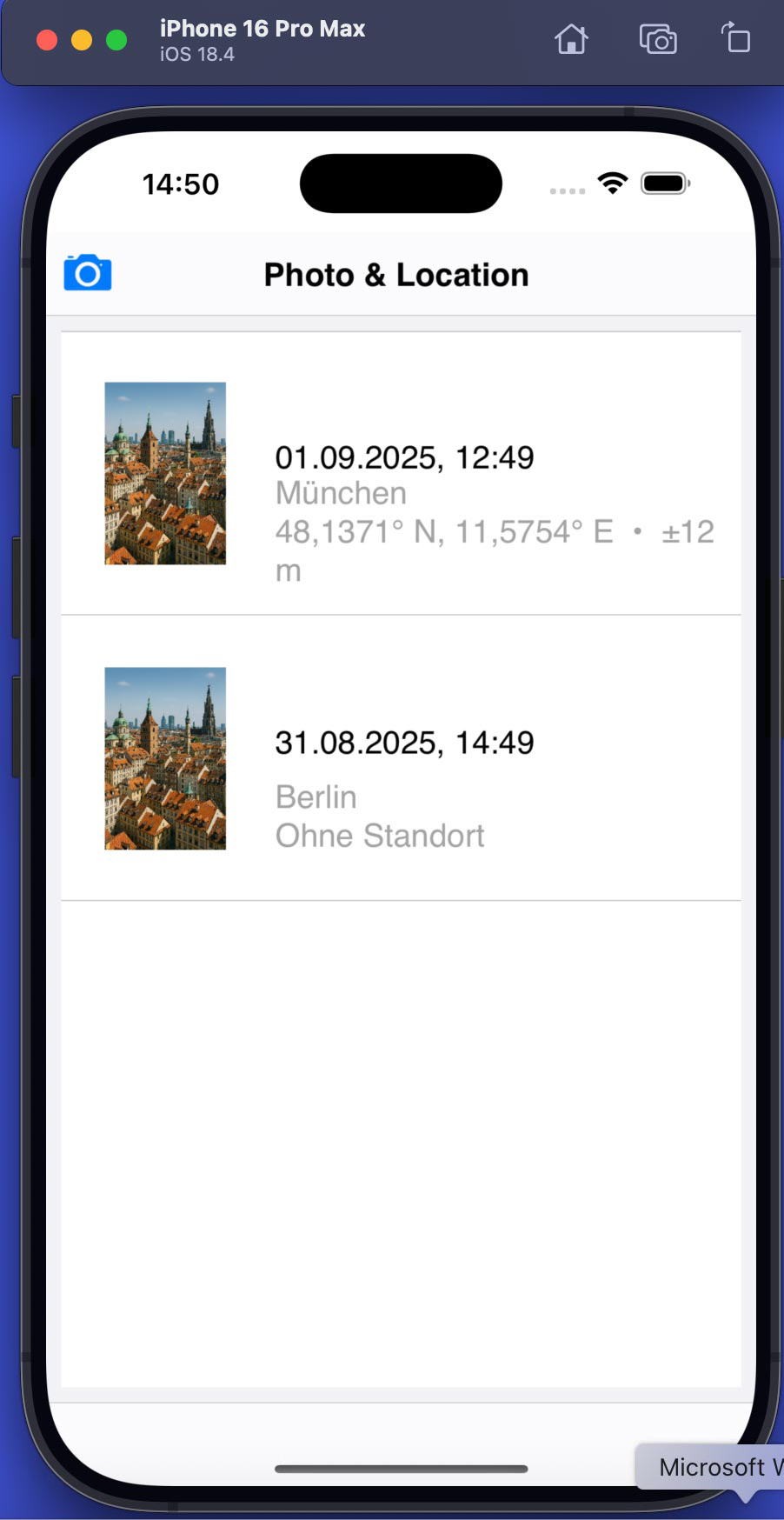

Einen ersten Eindruck vom geplanten Vorhaben liefert der folgende Prototyp (Abb. 12).

Sehen wir uns wesentliche Schritte der Umsetzung an:

-

Man kann beispielsweise die Vorlage Geräteübergreifende Anwendung mit Kopf- und Fußzeile auf der Basis von FireMonkey wählen. So erhält man ein Grundgerüst zur Gestaltung des User Interfaces auf mobilen Geräten.

-

Gestalten wir nun das User Interface des Hauptformulars: Dazu platzieren wir eine Kopf- und eine Fußzeile (TToolBar) sowie einen Layoutcontainer, der den restlichen Platz für die Medienliste (Content) einnimmt.

-

Als dynamische Liste verwenden wir eine TListView-Komponente. Diese können wir individuell gestalten, d. h., wir können festlegen, wie die einzelnen Listenelemente angezeigt werden.

-

Für die Datenhaltung definieren wir eine Klasse TPhoto, die die Daten zu den Bildern, Orten und Merkmalswerten verwaltet. Die Liste der Objekte wird in einem Datentyp nach dem Schema FPhotos: TObjectList<TPhoto> gespeichert.

-

Zum Aufnehmen von Bildern mit der Kamera bietet RAD Studio die Schnittstelle FMX.MediaLibrary.IFMXCameraService. Mit Hilfe dieser Schnittstelle kann die Kamera plattformübergreifend auf iOS und Android genutzt werden [6]. Denken Sie daran, die entsprechenden Berechtigungen für die Plattformen gemäß Dokumentation zu setzen.

-

Zur Ermittlung des Standorts steht die Komponente System.Sensors.Components.TLocationSensor zur Verfügung. Sie kapselt den Zugriff auf die Ortungsdienste für die Zielsysteme [7]. Auch hier sind Berechtigungen in den Projekteigenschaften erforderlich.

-

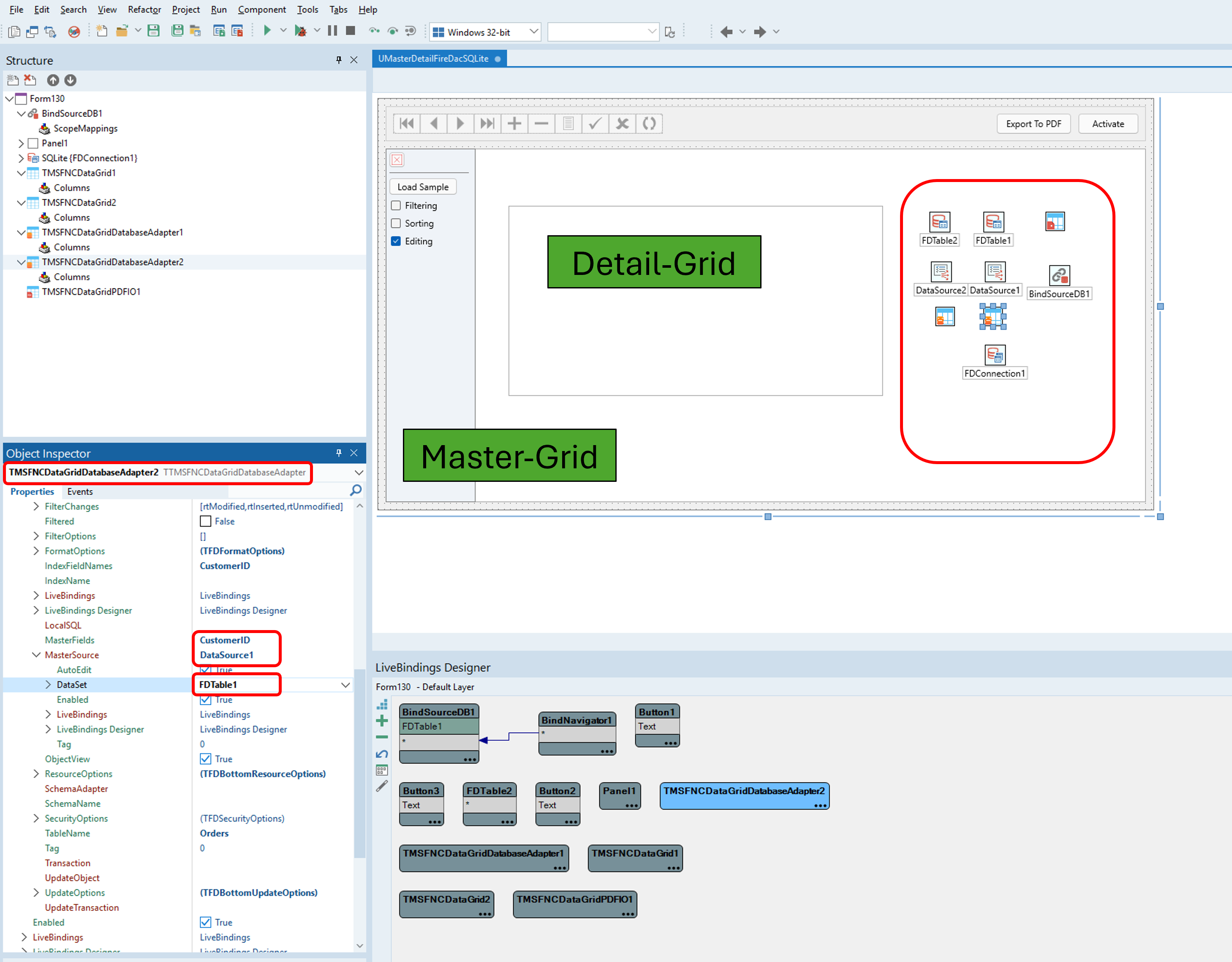

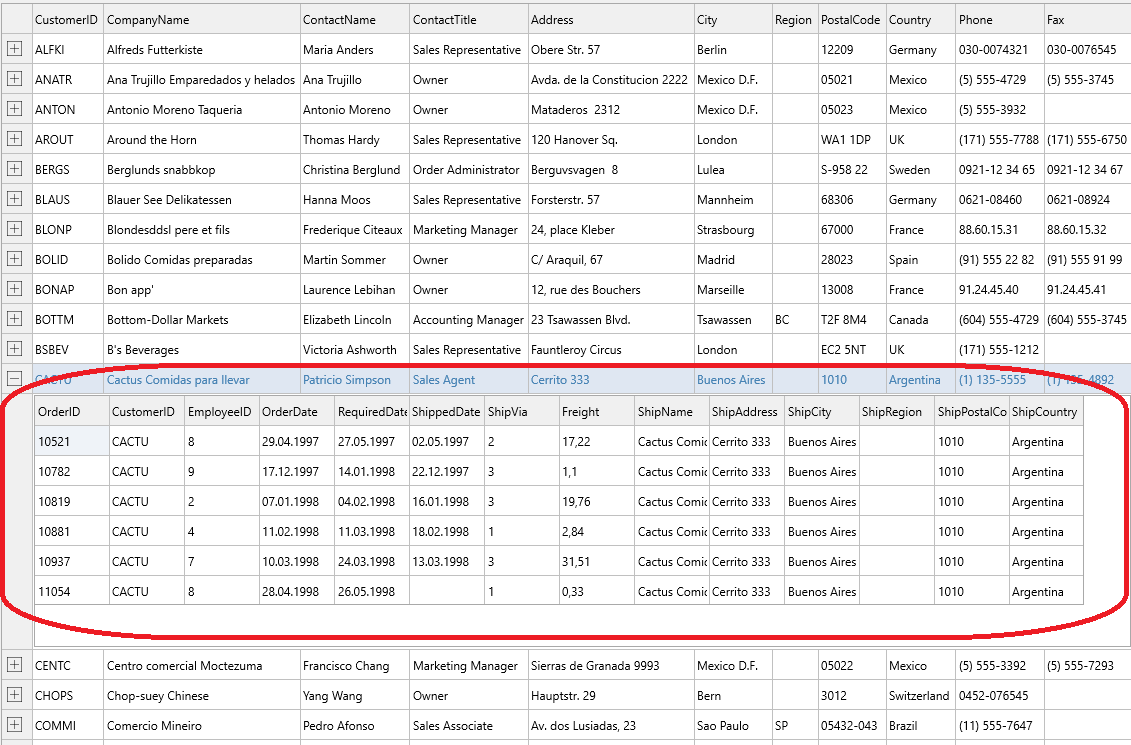

Die Datenspeicherung auf dem mobilen Device kann in einer lokalen SQLite-Datenbank erfolgen. Dazu wird aus Delphi die FireDAC-Bibliothek genutzt [8].

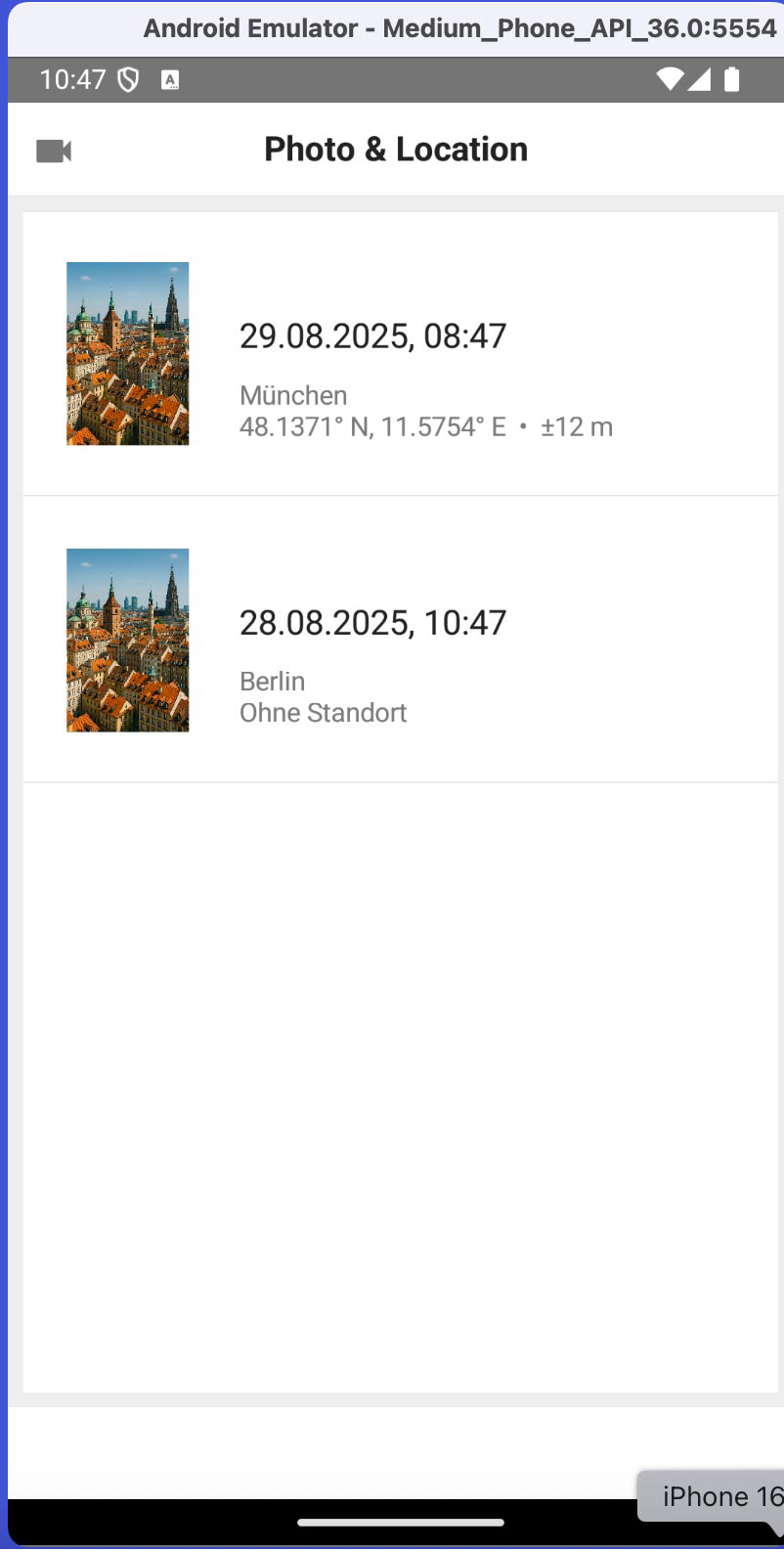

Mit diesen Schritten ist das grundsätzliche Vorgehen zur Programmierung unserer Beispiel-App für Android und iOS skizziert. Einen ersten Eindruck von der App auf iOS und Android vermitteln Abbildung 13 und 14.

Während der laufenden Entwicklung ist es oft sinnvoll, die Funktionsweise schnell zu überprüfen. Das kann in vielen Fällen dadurch geschehen, dass man die App direkt als Windows-Applikation ausführt. Dank der Cross-Platform-Fähigkeit ist das kein Problem.

Projekt und Quellcode

Das Beispielprojekt ist hier nur skizziert. Den Fortgang des Vorhabens können Sie auf GitHub unter [9] verfolgen und den Quellcode laden.

Bootcamp: Delphi Cross-Platform

Haben wir Ihr Interesse für die Mobile-Entwicklung mit RAD Studio (Delphi) geweckt? Dann vertiefen Sie das Thema doch in einem zweitägigen Bootcamp auf der diesjährigen EKON! Weitere Informationen finden Sie unter [10].

Fazit

Im Jahr 2025 eignet sich Delphi für geschäftliche Apps, Prototypen und alle Projekte, bei denen eine schnelle Entwicklung für mehrere Plattformen gefragt ist und die volle native Performance wichtig ist. Die Möglichkeiten reichen von klassischen Formular- und Datenbank-Apps über multimediale Anwendungen bis hin zu IoT-nahen Lösungen mit Sensorintegration. Die Grenzen liegen vor allem dort, wo extreme Plattformtreue im UI oder die maximale Nutzung des jeweiligen nativen Ökosystems verlangt wird – in diesen Fällen kann Delphi zwar mithalten, es ist jedoch mehr Handarbeit erforderlich. Für viele Anwendungen im üblichen Rahmen bietet Delphi jedoch einen ausgewogenen Kompromiss aus Entwicklungstempo, Codeeffizienz und Anwendungsleistung, wodurch es zu einer attraktiven Option für Mobile-Entwickler:innen wird.

Frequently Asked Questions (FAQ)

- Wofür eignet sich Delphi 2025 in der Mobile-Entwicklung?

Delphi eignet sich insbesondere für geschäftliche Apps, Prototypen und Cross-Plattform-Projekte, bei denen schnelle Entwicklung und native Performance gefragt sind. Es unterstützt Android, iOS und in Kombination auch Desktop-Plattformen. - Wie startet man ein Mobile-Projekt in Delphi?

Ein Mobile-Projekt wird in der IDE über „Datei | Neu | Multi-Device-Anwendung“ angelegt. Vorlagen wie leere Anwendungen oder Tabbed Templates liefern eine Grundstruktur für Android und iOS. - Wie wird das User Interface mit FireMonkey gestaltet?

Die UI wird im grafischen Multi-Device-Designer per Drag-and-Drop erstellt. Master-Formulare dienen allen Geräten, während View-Varianten für unterschiedliche Auflösungen und Formfaktoren nachjustiert werden können. - Wie erfolgt der Zugriff auf Gerätesensoren?

Delphi stellt Komponenten wie TLocationSensor, TMotionSensor, TOrientationSensor und TCameraComponent bereit. Diese abstrahieren die Plattformunterschiede und erlauben den Zugriff auf GPS, Bewegungssensoren, Kamera und weitere Hardware. - Welche Berechtigungen müssen Entwickler berücksichtigen?

Für Sensoren wie Kamera, GPS oder Mikrofon müssen Berechtigungen in den Projekteinstellungen hinterlegt werden. Neuere Android- und iOS-Versionen erfordern zusätzlich Runtime Permissions, die Delphi unterstützt. - Kann Delphi auf plattformspezifische APIs zugreifen?

Ja, über Bridge Units, Header-Übersetzungen und Namespaces wie iOSapi.Foundation oder Java2OP können native Funktionen direkt genutzt werden. So lassen sich Apple- oder Android-spezifische Features in Delphi einbinden. - Welche Projektarten profitieren besonders von Delphi?

Delphi eignet sich für Business- und Enterprise-Apps, Cross-Plattform-Projekte mit knapper Timeline, Industrieanwendungen mit spezieller Hardware und Multi-Platform-Desktop-Mobile-Kombinationsprojekte. - Wo liegen die Grenzen von Delphi in der Mobile-Entwicklung?

Delphi ist weniger geeignet für grafikintensive Spiele, extrem plattformtreue UI-Anforderungen oder komplexe Drittanbieter-Frameworks. Auch das Tooling und die Community sind im Vergleich zu Xcode oder Android Studio begrenzter.

Links & Literatur

[1] https://www.embarcadero.com/products/rad-studio/whats-new-in-12-athens

[4] https://docwiki.embarcadero.com/RADStudio/Athens/de/Installieren_des_Platform_Assistant_auf_dem_Mac.

[5] https://www.macincloud.com

[6] https://docwiki.embarcadero.com/RADStudio/Athens/en/Taking_Pictures_Using_FireMonkey_Interfaces

[9] https://github.com/veikkoEF/PhotoAndLocation/settings

[10] https://entwickler-konferenz.de/bootcamp-delphi-cross-platform-entwicklung-fuer-ios-und-android

The post Entwicklungspraxis, Sensorik und Bewertung von Delphi Mobile appeared first on Entwickler Konferenz.

]]>The post Cross-Platform-Setup – iOS- und Android-Entwicklung mit RAD Studio appeared first on Entwickler Konferenz.

]]>Set-up und Konfiguration für iOS-Apps

Der iOS-Simulator läuft unter macOS. Dieser soll aus RAD Studio (Windows) angesprochen werden, d. h., wir möchten das App-Package darauf installieren.

-

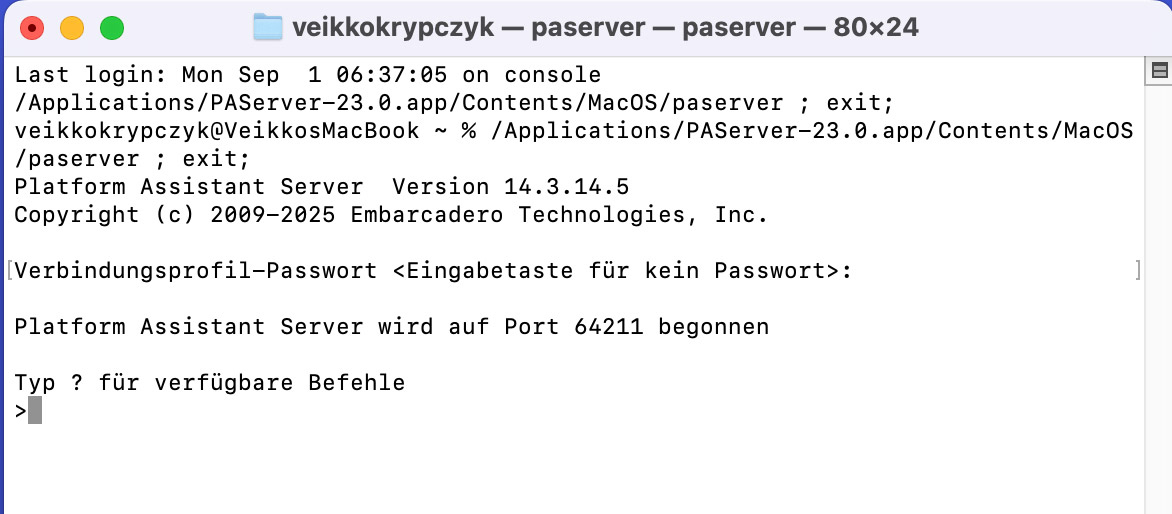

Installation unter macOS: Zunächst ist es notwendig, unter macOS die integrierte Entwicklungsumgebung Xcode (kostenfrei im App-Store erhältlich) zu installieren. Der Simulator für iOS wird im Zusammenhang mit Xcode eingerichtet. Über die Einstellungen von Xcode können auch unterschiedliche Versionen des Simulators (iPhone, iPad, verschiedene iOS-Versionen) installiert werden. Nach der Installation können Sie die Funktionsfähigkeit des Simulators eigenständig prüfen. Eventuell werden beim ersten Start noch notwendige Befehlszeilentools nachträglich eingerichtet. Um den iOS-Simulator aus RAD Studio über das Netzwerk fernzusteuern, wird das Tool PAServer (Platform Assistent Server) benötigt. Dieses können Sie von der Embarcadero-Webseite (RAD Studio) herunterladen. Die passende PAServer-Version zur entsprechenden RAD-Studio-Version finden Sie unter [4]. Achten Sie insgesamt darauf, dass die Versionen von iOS, Xcode, RAD Studio und PAServer miteinander kompatibel sind. Wenn etwas nicht funktioniert und die Fehlermeldung nicht eindeutig ist bzw. die Ursache unklar ist, kann eine neue Version eines Tools bereits die Lösung sein. Das Problem der Kompatibilität unterschiedlicher Softwareversionen tritt bei allen plattformübergreifenden Ansätzen zutage. Es kann also problematisch werden, wenn man unbedacht ein Update anstößt. Ein Beispiel: Man aktualisiert die iOS-Version auf seinem Endgerät. Um Apps für diese neue Version zu erstellen, ist auch ein Update von Xcode notwendig. So weit, so gut. Gleichzeitig muss jedoch auch die IDE RAD Studio mit den neuen Versionen von Xcode und iOS kompatibel sein. Hier gilt also: Nicht jedes Update sollte unmittelbar – ohne Prüfung der Auswirkungen auf die gesamte Entwicklungsumgebung – installiert werden. Etwas Sorgfalt zahlt sich hier oftmals aus. Mit diesen Schritten ist die Einrichtung auf macOS abgeschlossen. Wir notieren (kopieren) noch die IP-Adresse des Macs, um diesen über das Netzwerk erreichen zu können. Zum Abschluss starten wir PAServer. Bei aktivierter Instanz bleibt das zugehörige Terminalfenster geöffnet (Abb. 1).

-

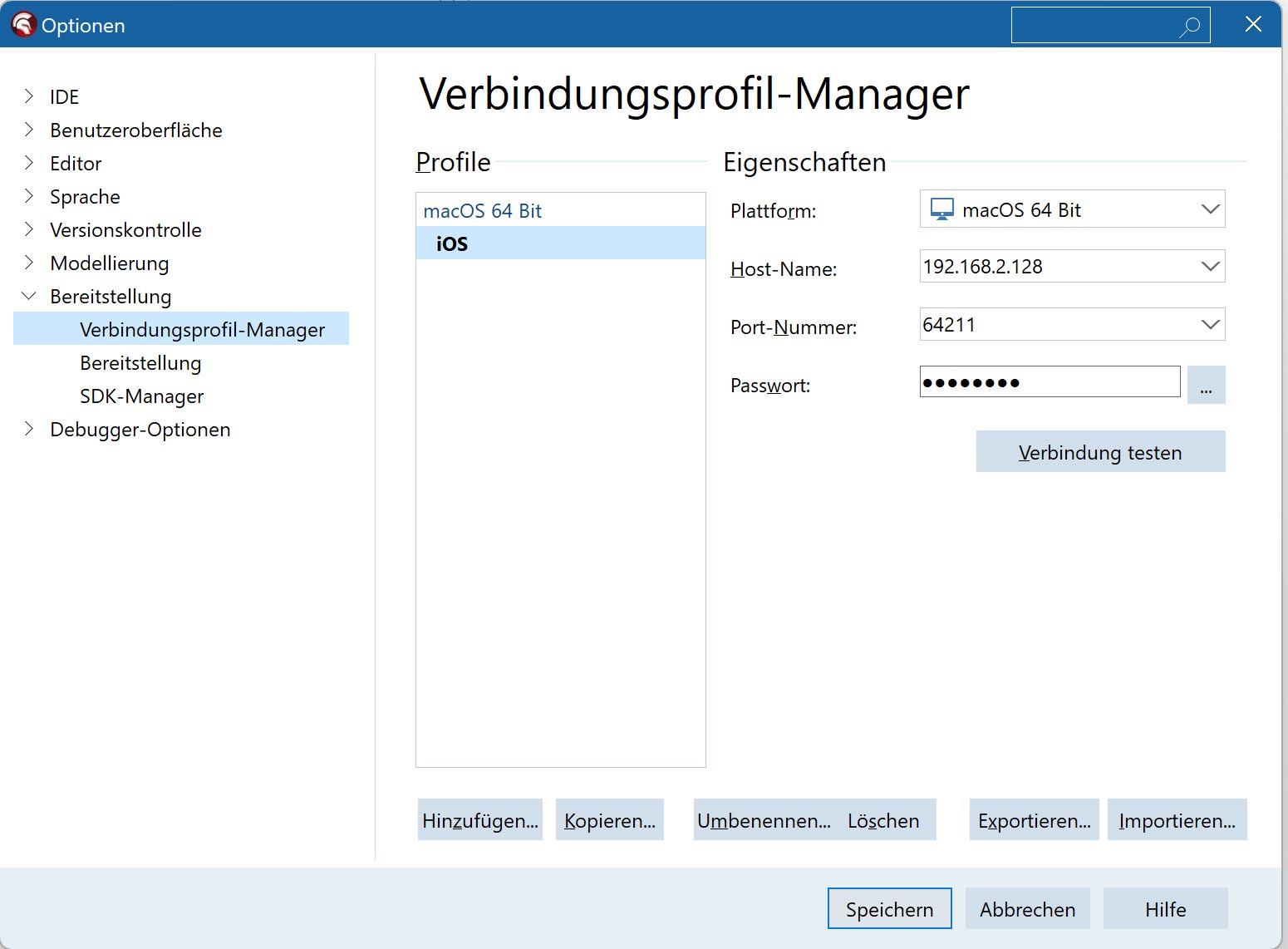

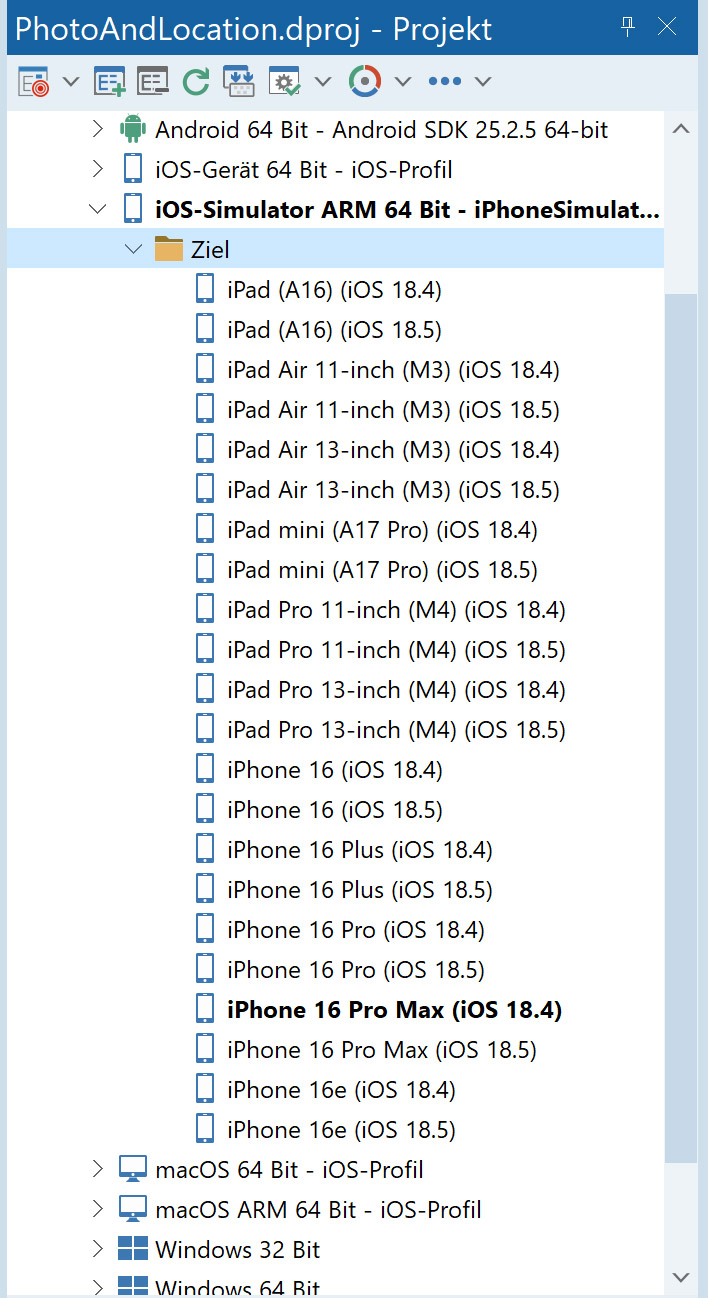

Installation unter Windows: In RAD Studio aktivieren wir das Ziel iOS-Simulator im Projektmappen-Explorer. Anschließend müssen wir das entsprechende iOS-SDK zuweisen und installieren. Außerdem soll eine Verbindung zum Mac hergestellt werden. Dazu ist die IP-Adresse im entsprechenden Dialogfeld von RAD Studio einzugeben (Abb. 2). Sind diese Schritte abgeschlossen, werden die verfügbaren iOS-Simulatoren im Projektmappen-Explorer angezeigt (Abb. 3). Nun kann die aktive App auf dem ausgewählten Gerät installiert, ausgeführt und bei Bedarf auch debuggt werden.

Set-up und Konfiguration für Android-Apps

Wir sollen einen Android-Emulator unter macOS (ARM) einrichten und ihn über eine Netzwerkverbindung aus der virtuellen Maschine heraus mit RAD Studio nutzen. Dazu müssen wir die folgenden Schritte ausführen:

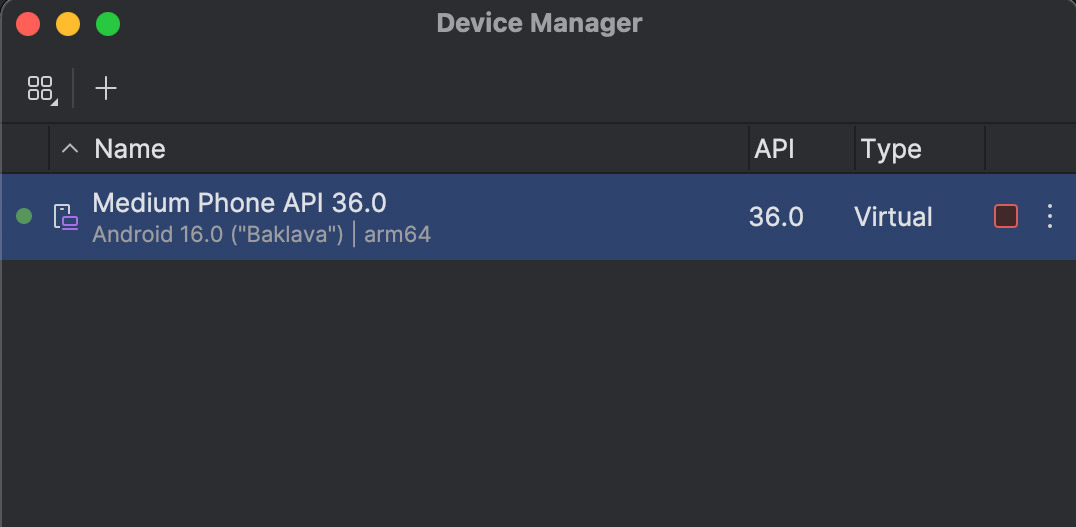

Installation des Emulators unter macOS: Am besten laden Sie Android Studio für macOS/ARM herunter und installieren es. Über das Startmenü von Android Studio kann man unmittelbar den Virtual Device Manager für die virtuellen Geräte aufrufen und mit dessen Hilfe einen Android-Emulator einrichten (Abb. 4).

Ist das erfolgt, testen Sie direkt den Start des Emulators. Sie werden die gute Performance auf einem ARM-Gerät spüren. Für den Zugriff auf den Emulator von „außen“ (Netzwerk) benötigen wir das Tool ADB (Android Debug Bridge). ADB ist ein zentrales Entwicklerwerkzeug im Android-Ökosystem, das eine direkte Schnittstelle zwischen einem Computer und einem Android-Gerät bereitstellt. Es ermöglicht die Verbindung von Geräten über USB oder ein Netzwerk und die Ausführung vielfältiger Aktionen – vom Installieren und Testen von Apps über den Zugriff auf Systemlogs bis hin zur Steuerung des Geräts per Kommandozeile. Typische Anwendungsfälle sind die Installation von APK-Dateien, das Auslesen von Logdaten zur Fehlersuche oder der Start einer interaktiven Shell, um direkt mit dem Android-Betriebssystem zu arbeiten. ADB installieren Sie (wenn noch nicht geschehen) über den SDK-Manager. Diesen erreichen Sie am einfachsten auch über Android Studio. Installieren Sie die Android SDK Platform-Tools. Ist das erfolgreich erledigt, dann können wir über die Konsole mit der ADB arbeiten.

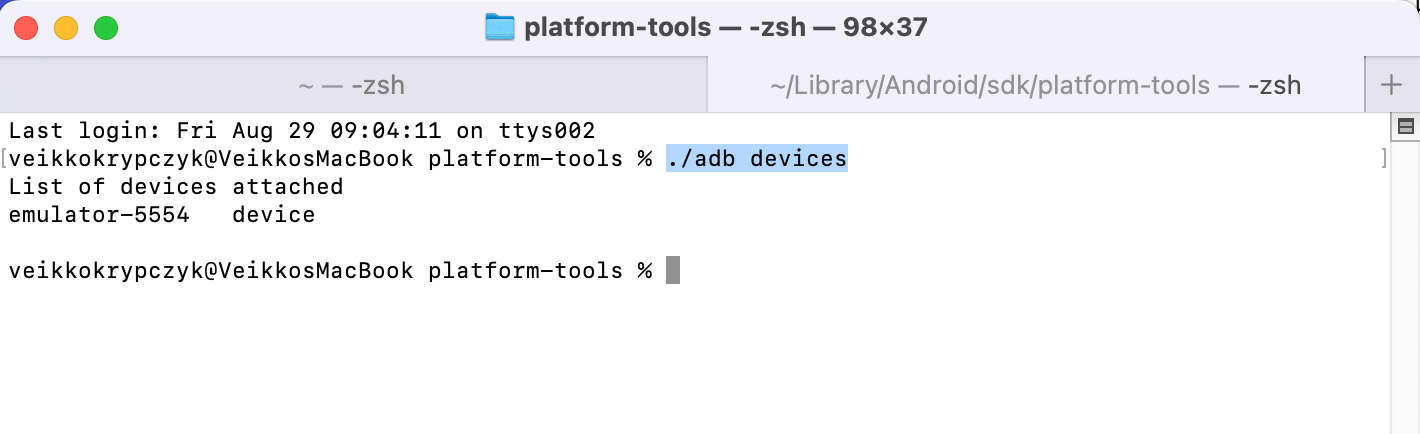

Arbeiten auf macOS: Suchen Sie auf macOS den Pfad, unter dem die Android-SDK-Platform-Tools installiert sind. Das ist üblicherweise der Ordner ~/Library/Android/sdk/platform-tools. Öffnen Sie diesen Pfad in einem Terminal auf macOS. Starten Sie ebenfalls den zuvor installierten Emulator. Mit dem Befehl

./adb devicessollte eine Liste der aktuellen (laufenden) Emulatoren angezeigt werden (Abb. 5).

Prüfen Sie dies, da die nächsten Schritte sonst nicht funktionieren. Damit der Emulator über das Netzwerk erreichbar ist, muss der ADB-Server gestartet und so konfiguriert werden, dass er auf eingehende Netzwerkabfragen lauscht. Das erreichen Sie folgendermaßen: Zuerst muss ein möglicherweise laufender Server mit dem folgenden Befehl beendet werden:

./adb kill-serverNun können wir den Server neu starten und so konfigurieren, dass er auf eingehende Netzwerkverbindungen lauscht. Geben Sie dazu im Terminal ein:

./adb -a -P 5037 nodaemon serverSie erhalten verschiedene Logging-Meldungen und das Terminalfenster bleibt intern blockiert. Das ist der Hinweis, dass der Server läuft (Abb. 6).

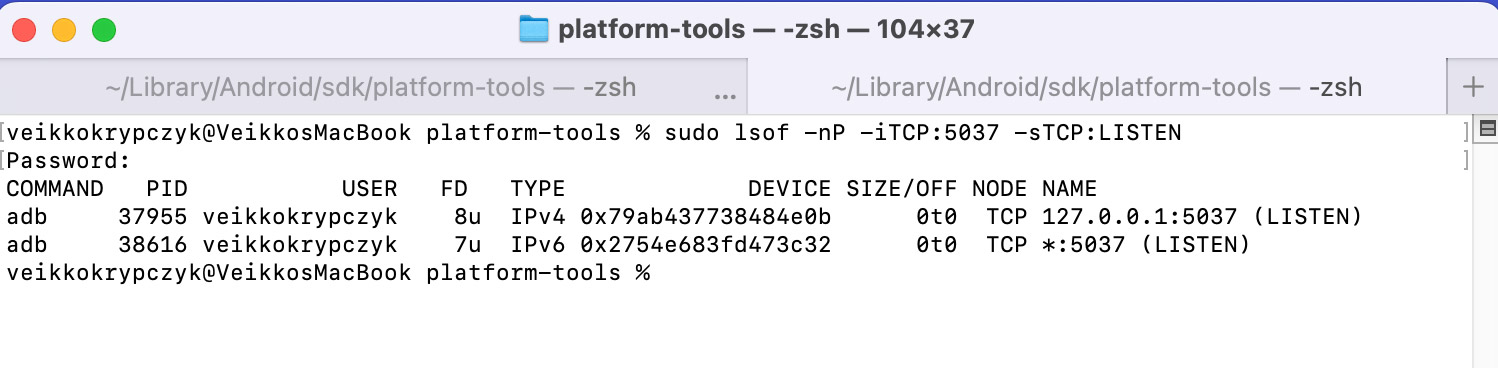

Lassen Sie das Terminalfenster unbedingt geöffnet. Öffnen Sie auf macOS ein zweites Terminal-Fenster und prüfen Sie den Status des Servers mit folgendem Befehl:

sudo lsof -nP -iTCP:5037 -sTCP:LISTENSie werden zur Passworteingabe aufgefordert und erhalten eine Ausgabe, die angibt, auf welchen Netzwerkkanälen der ADB-Server lauscht. Wichtig ist der Verweis auf TCP/IP und den Port 5037. In der Standardkonfiguration lauscht der Server auf localhost (127.0.0.1). Mit unserem Befehl haben wir ihn dazu gebracht auch auf die eingehende Netzwerkverbindung zu achten. Ist das geschafft, ist die Konfiguration auf Seiten von macOS abgeschlossen. Weiter geht es mit Windows in unserer virtuellen Maschine.

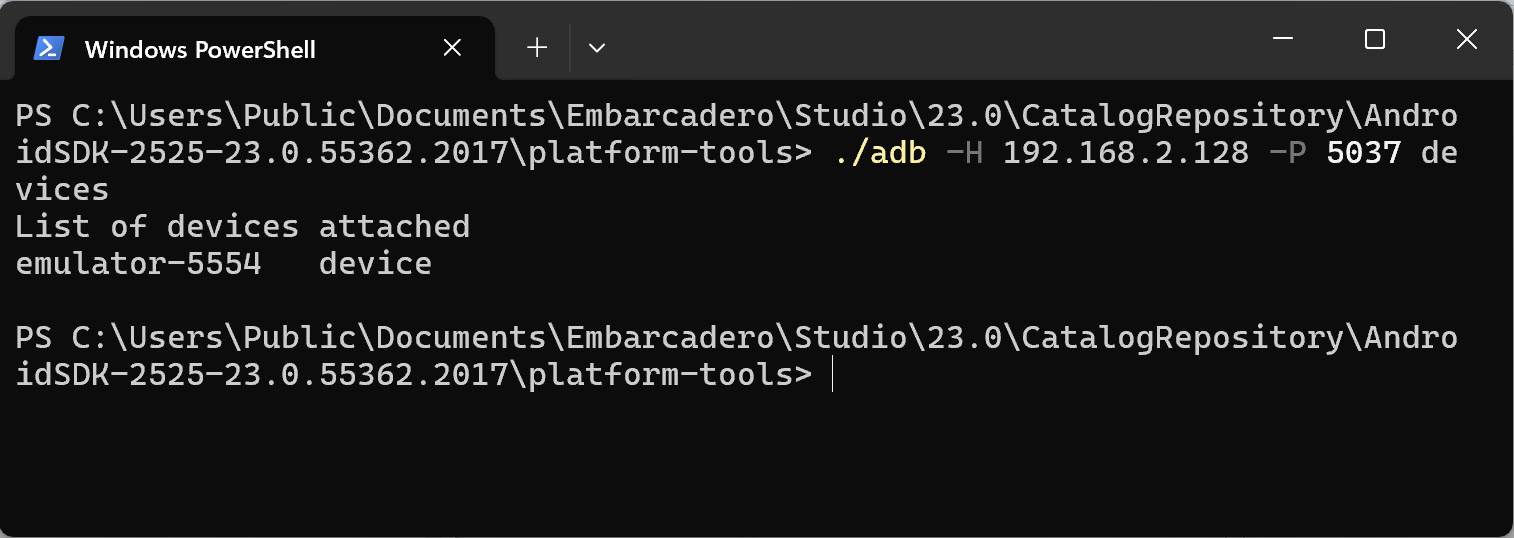

Arbeiten unter Windows: Mit der Installation von RAD Studio wurde die Plattform Android hinzugefügt. Auch unter Windows benötigen wir die Android-SDK-Tools. Sofern die Installation vollständig ist, finden sich die SDK-Tools in der Regel im folgenden Verzeichnis: C:\Users\Public\Documents\Embarcadero\Studio\23.0\CatalogRepository\AndroidSDK-2525-23.0.55362.2017\platform-tools>.

Wechseln Sie in der Windows PowerShell in dieses Verzeichnis. Ebenso benötigen wir die IP-Adresse des Macs. Wechseln Sie dazu erneut auf den Mac und notieren bzw. kopieren Sie die IP-Adresse aus den Netzwerkeinstellungen. Geben Sie in der PowerShell-Konsole folgenden Befehl ein:

setx ADB_SERVER_SOCKET "tcp:192.168.2.128:5037"Ersetzen Sie diese IP-Adresse durch die IP-Adresse Ihres Macs. Den Port belassen Sie auf 5037. Damit weisen Sie die ADB unter Windows an, die verfügbaren Geräte über das Netzwerk abzurufen. Anschließend sollten Sie die folgende Meldung erhalten: „ERFOLGREICH: Angegebener Wert wurde gespeichert.“

Nun folgt der spannende Test, ob wir den laufenden Android-Emulator von macOS von Windows aus sehen können. Geben Sie dazu in die PowerShell-Konsole ein:

./adb -H 192.168.2.128 -P 5037 DeviseBitte ersetzen Sie wieder den Wert der IP-Adresse. Das Ergebnis sollte eine Liste der Android-Emulatoren von macOS sein (Abb. 7).

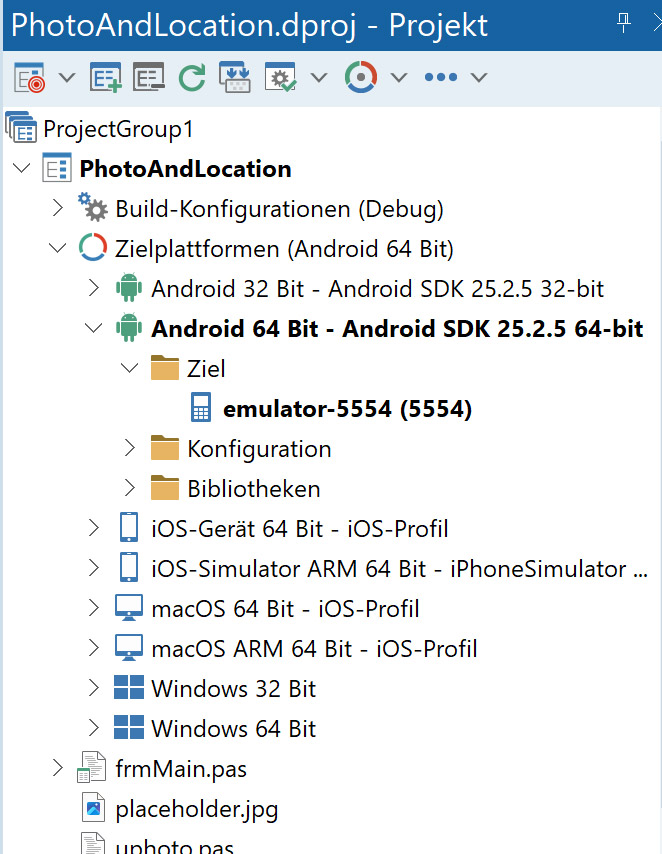

Android Emulator in RAD Studio verwenden: Starten Sie RAD Studio neu und öffnen Sie ein Multi-Device-Projekt, das unter anderem Android als Zielsystem hat. Im Projektmappen-Explorer wechseln Sie zu Zielsysteme | Android 64-Bit. Beim ersten Aufruf müssen Sie hier ggf. noch das Android-SDK zuweisen. Aktualisieren Sie anschließend den Pfadziel (Abb. 8).

Darunter sollte der Emulator, also das virtuelle Android-Gerät, erscheinen. Wenn das der Fall ist, haben Sie einen wichtigen Schritt gemeistert. Nun können Sie Ihre App aus RAD Studio auf dem Android-Emulator unter macOS ausführen. Herzlichen Glückwunsch!

Im dritten Teil unserer Serie zeigen wir ein praxisnahes Beispiel für die Umsetzung einer Mobile-App mit Delphi, inklusive Kamera, Geodaten und lokaler Datenspeicherung.

Frequently Asked Questions (FAQ)

- Welche Voraussetzungen sind notwendig, um einen iOS-Simulator unter macOS einzurichten?

Man benötigt Xcode, das kostenlos im Mac App Store erhältlich ist, sowie die Installation der gewünschten Simulator-Versionen über die Xcode-Einstellungen. Zusätzlich müssen eventuelle Befehlszeilentools installiert und PAServer für die Netzwerkverbindung zu RAD Studio eingerichtet werden. - Wie stellt RAD Studio auf Windows eine Verbindung zum iOS-Simulator auf dem Mac her?

In RAD Studio wird das iOS-SDK zugewiesen, das Ziel iOS-Simulator aktiviert und die IP-Adresse des Macs eingegeben. Nach Abschluss werden die verfügbaren Simulatoren im Projektmappen-Explorer angezeigt. - Was ist PAServer und welche Funktion erfüllt es?

PAServer (Platform Assistant Server) ermöglicht die Fernsteuerung des iOS-Simulators über das Netzwerk von RAD Studio aus. Es muss auf dem Mac gestartet und eine aktive Terminalinstanz geöffnet bleiben. - Wie wird ein Android-Emulator unter macOS installiert und getestet?

Android Studio wird installiert, anschließend über den Virtual Device Manager ein Emulator erstellt. Der Start des Emulators sollte direkt überprüft werden, um die Funktion und Performance zu testen. - Welche Rolle spielt ADB bei der Nutzung eines Android-Emulators von externen Systemen?

ADB (Android Debug Bridge) stellt eine Schnittstelle zwischen Computer und Android-Gerät bereit, ermöglicht Installation, Test und Debugging von Apps sowie Zugriff auf Systemlogs. Für die Netzwerkverbindung muss der ADB-Server gestartet und für eingehende Verbindungen konfiguriert werden. - Wie wird der Android-Emulator von macOS aus in einer Windows-Umgebung zugänglich gemacht?

Unter Windows wird die IP-Adresse des Macs in der PowerShell mit setx ADB_SERVER_SOCKET eingetragen. Anschließend kann der Emulator über den Befehl ./adb -H <IP> -P 5037 devices aufgelistet werden. - Wie kann der Android-Emulator in RAD Studio genutzt werden?

Nach Neustart von RAD Studio wird das Multi-Device-Projekt geöffnet, das Android als Zielsystem enthält. Der Pfad zum Android-SDK wird ggf. zugewiesen, danach erscheint der Emulator im Projektmappen-Explorer und kann zum Ausführen von Apps verwendet werden. - Welche Kompatibilitätsaspekte sind bei plattformübergreifender Entwicklung zu beachten?

Versionen von iOS, Xcode, RAD Studio und PAServer müssen miteinander kompatibel sein. Updates sollten nur nach Prüfung der Auswirkungen auf die gesamte Entwicklungsumgebung durchgeführt werden, um Probleme zu vermeiden.

Links & Literatur

[1] https://www.embarcadero.com/products/rad-studio/whats-new-in-12-athens

[4] https://docwiki.embarcadero.com/RADStudio/Athens/de/Installieren_des_Platform_Assistant_auf_dem_Mac.

[5] https://www.macincloud.com

[6] https://docwiki.embarcadero.com/RADStudio/Athens/en/Taking_Pictures_Using_FireMonkey_Interfaces

[9] https://github.com/veikkoEF/PhotoAndLocation/settings

[10] https://entwickler-konferenz.de/bootcamp-delphi-cross-platform-entwicklung-fuer-ios-und-android

The post Cross-Platform-Setup – iOS- und Android-Entwicklung mit RAD Studio appeared first on Entwickler Konferenz.

]]>The post Delphi for Mobile – Grundlagen, Plattformen und Entwicklungsumgebung appeared first on Entwickler Konferenz.

]]>Zielplattformen und Anforderungen

Mit Blick auf die Mobile-Plattformen unterstützt RAD Studio seit dem Update auf Version 12.3 iOS 18 und Android 15 mit API-Level 35 [1]. Delphi läuft ausschließlich auf einem Windows-Betriebssystem. Für die plattformspezifische Entwicklung (Android, iOS) sind daher spezifische Build-Schritte notwendig. Für iOS bedeutet das: Kompilierung, Signierung und Deployment erfolgen über einen Mac mit installiertem Xcode und PAServer. Delphi unterstützt den iOS-Simulator, jedoch ausschließlich auf ARM-basierten Macs, d. h. den neueren Prozessoren Apple Silicon M1 bis M4. Im Umkehrschluss bedeutet das, dass eine entwickelte iOS-App nicht auf dem Simulator eines Intel-Macs gestartet werden kann [2]. In diesem Fall bleibt nur der Test auf physischen Geräten, d. h., man muss ein iPhone via WLAN oder USB mit dem Mac koppeln.

Für Android ist die vollständige Toolchain (SDK, NDK, Gradle und Emulatoren) direkt in die IDE integriert. Zwar lassen sich Apps auch im Android-Emulator ausführen, dieser ist jedoch oft sehr langsam und bietet nur eingeschränkten Support für Hardwarefunktionen wie GPS, Kamera oder Sensoren. Embarcadero, das Unternehmen, das Delphi entwickelt und vertreibt, empfiehlt deshalb, für Tests ein physisches Android-Gerät zu verwenden [3]. Auf diesen Punkt kommen wir im Laufe des Artikels nochmals zurück. Die Kombination aus Entwicklung auf einem Windows-Rechner und plattformspezifischer Build-Infrastruktur ist durch die Nutzung von mehreren Betriebssystemen (Windows, macOS, Android, iOS) durchaus komplex, jedoch auch ein typisches Merkmal der plattformübergreifenden Programmierung.

Systemumgebung aufsetzen

Die Entwicklung von Cross-Platform-Apps, d. h. in diesem Fall von Apps für mobile Geräte mit den Betriebssystemen iOS und Android, erfordert einige Überlegungen und gelegentlich auch etwas „Bastelarbeit“. Im Folgenden wird eine Konfiguration vorgestellt, die eine gute Ausgangsbasis für die Entwicklung von Mobile-Apps darstellt und die Nutzung von Emulator (Android) und Simulator (iOS) ermöglicht. Wir gehen auf die folgenden Punkte ein:

-

Systemumgebung: Windows mit RAD Studio

-

Verbindung zu einem iOS-Simulator

-

Verbindung zu einem Android-Emulator

Entwicklermaschine mit RAD Studio auf Windows in einer virtuellen Maschine

Als Entwicklermaschine haben wir einen leistungsstarken Mac, beispielsweise ein MacBook Pro, gewählt. Damit ist eine Entwicklung für beide Zielsysteme (iOS und Android) möglich. Prinzipiell ist auch eine Entwicklung für die Desktopsysteme Windows, macOS und Linux möglich, die hier jedoch außen vor bleibt. Es kommt ein Mac mit einem ARM-Prozessor (M1 bis M4) und ausreichend Arbeitsspeicher sowie CPU-Leistung zum Einsatz.

Für diese Wahl gibt es mehrere Gründe. Zum einen kann der iOS-Simulator aus RAD Studio nur in der ARM-Version genutzt werden (siehe oben). Auch der Android-Emulator arbeitet auf einem ARM-Prozessor besser. Delphi kompiliert native Android-Apps, die unmittelbar auf den Android-Geräten installiert und ausgeführt werden. Um traditionell einen Android-Emulator auf einem Desktop-PC (x64-Architektur) nutzen zu können, musste beim Aufsetzen des Emulators ein entsprechendes x64-Image gewählt werden. Wurde ein ARM-Image gewählt, musste der Hostcomputer die Übersetzung zwischen den Betriebssystemen (x64 nach ARM) aufwendig durchführen. Das führte zu einer sehr langsamen Ausführungsgeschwindigkeit des Android-Emulators.

Da Delphi native, ARM-basierte Android-Apps kompiliert, konnten diese nicht vernünftig auf einem Emulator getestet werden. In der Dokumentation wurde daher darauf hingewiesen, dass man zum Testen besser direkt ein physisches Gerät einsetzt. Mit den neuen ARM-Prozessoren von Macs sieht die Sache anders aus. Hier entfällt die Übersetzung zwischen ARM- und x64-Architekturen, da sowohl macOS als auch Android auf der ARM-Architektur basieren.

Zur Einrichtung der Entwicklungsumgebung nutzen wir die Virtualisierungslösung Parallels unter macOS. In Parallels können wir ein Windows-System installieren. Dabei installiert Parallels die ARM-Version von Windows. Die Installation und Einrichtung erfolgen zügig und werden durch einen Assistenten von Parallels unterstützt. Auf dem ARM-basierten Windows kann anschließend RAD Studio nach bekanntem Muster installiert werden. Windows ARM kann auch x64-Programme ausführen.

Es gelten jedoch folgende Zusammenhänge: RAD Studio selbst existiert derzeit nicht als native ARM64-Version für Windows, sondern ausschließlich für klassische x86- und x64-Systeme. Auf einem Windows-on-ARM-Gerät (hier eine virtuelle Maschine) wird die IDE daher über die integrierte Emulationsschicht von Windows 11 ausgeführt. Diese Emulation ermöglicht die Ausführung von 32- und 64-Bit-x86-Anwendungen und stellt somit eine hohe Kompatibilität sicher. Ist die Hardwareplattform ausreichend leistungsfähig, sind Einschränkungen in der Ausführungsgeschwindigkeit nicht störend bzw. nicht bemerkbar. Insbesondere bei rechenintensiven Aufgaben und größeren Projekten kann dieser Umstand jedoch von Bedeutung sein. Auch die mit RAD Studio erzeugten Windows-Anwendungen liegen standardmäßig als Win32- oder Win64-Binarys vor und laufen auf Windows-on-ARM ebenfalls nur über die Emulation. Eine direkte Unterstützung der Zielplattform Windows ARM64 ist derzeit nicht vorgesehen, anders als bei iOS, Android oder Linux, wo RAD Studio bereits native ARM-Compiler anbietet. Das bedeutet für Entwickler:innen, dass ihre Delphi- oder C++Builder-Anwendungen auf ARM-basierten Windows-Geräten zwar grundsätzlich lauffähig sind, jedoch nicht die Performance erreichen, die mit einer nativen ARM64-Build-Toolchain möglich wäre.

Zusammenfassend können wir festhalten, dass wir RAD Studio zur Entwicklung auf einem ARM-basierten Windows ausführen können und keine größeren Einschränkungen festgestellt haben. Auch Windows-Apps (hier nur für Tests interessant) lassen sich damit erstellen.

Kommen wir nun zur Einrichtung der Systemkonfiguration für die Erstellung von Mobile-Apps für iOS (Simulator) und Android (Emulator). Beginnen wir mit iOS.

Dies ist der erste Teil unserer Artikelserie „Mobile-Apps mit Delphi – eine Review über Möglichkeiten und Grenzen“. Im nächsten Artikel erfährst du mehr über die konkrete Projektanlage, das UI-Design mit FireMonkey und die Nutzung von Gerätesensoren. Anschließend folgt der dritte Teil mit einem praxisnahen Beispiel für die App-Entwicklung.

Frequently Asked Questions (FAQ)

- Was ist Delphi for Mobile und wofür wird es verwendet?

Delphi for Mobile ist eine Entwicklungsumgebung für native Mobile-Apps, die es ermöglicht, Android- und iOS-Anwendungen aus einer gemeinsamen Codebasis zu erstellen. Der Fokus liegt auf schneller Entwicklung (Rapid Application Development) und nativer Performance. - Welche Plattformen und Betriebssysteme werden unterstützt?

RAD Studio 12.3 unterstützt Android 15 (API-Level 35) und iOS 18. Die Entwicklungsumgebung selbst läuft ausschließlich auf Windows, für iOS-Builds wird zusätzlich ein Mac mit Xcode und PAServer benötigt. - Wie funktioniert die plattformübergreifende Entwicklung mit Delphi?

Mit dem FireMonkey-Framework (FMX) lassen sich Benutzeroberflächen für Android und iOS gleichzeitig grafisch gestalten. Object Pascal wird direkt zu nativen Binarys kompiliert, wodurch keine Laufzeitumgebungen oder virtuelle Maschinen auf den Zielgeräten benötigt werden. - Welche Voraussetzungen gelten für die Nutzung von Simulatoren und Emulatoren?

iOS-Simulatoren werden nur auf ARM-basierten Macs (Apple Silicon M1–M4) unterstützt; Intel-Macs benötigen physische Geräte. Android-Emulatoren sind in der IDE integriert, laufen aber oft langsam, weshalb für Tests physische Android-Geräte empfohlen werden. - Wie wird die Entwicklungsumgebung für Mobile-Apps eingerichtet?

Die Basis ist ein Windows-Rechner mit RAD Studio, der über Parallels auf einem ARM-basierten Mac virtualisiert werden kann. So lassen sich sowohl der iOS-Simulator als auch der Android-Emulator nutzen, wobei die Emulation von x86/x64 auf ARM erfolgt. - Welche Einschränkungen bestehen bei der Nutzung von Windows-on-ARM?

RAD Studio läuft auf Windows-on-ARM nur über die integrierte Emulation für x86- und x64-Programme. Native ARM64-Builds für Windows werden derzeit nicht unterstützt, was die Performance bei rechenintensiven Projekten begrenzen kann. - Welche Komponenten und Tools beschleunigen die App-Entwicklung?

FireMonkey für UI-Design, FireDAC für Datenzugriff und ein konfigurierbarer REST-Client ermöglichen schnelle Umsetzung. Komponentenwiederverwendung und visuelles Design tragen zusätzlich zur Entwicklungsbeschleunigung bei. - Für welche Szenarien eignet sich Delphi besonders? Delphi eignet sich für Projekte, die schnelle Markteinführung, native Performance und eine gemeinsame Codebasis für Android und iOS erfordern. Der gleiche Code könnte auch für Desktop-Systeme wie Windows, macOS oder Linux genutzt werden, wird hier aber nicht im Detail behandelt.

Links & Literatur

[1] https://www.embarcadero.com/products/rad-studio/whats-new-in-12-athens

[4] https://docwiki.embarcadero.com/RADStudio/Athens/de/Installieren_des_Platform_Assistant_auf_dem_Mac.

[5] https://www.macincloud.com

[6] https://docwiki.embarcadero.com/RADStudio/Athens/en/Taking_Pictures_Using_FireMonkey_Interfaces

[9] https://github.com/veikkoEF/PhotoAndLocation/settings

[10] https://entwickler-konferenz.de/bootcamp-delphi-cross-platform-entwicklung-fuer-ios-und-android

The post Delphi for Mobile – Grundlagen, Plattformen und Entwicklungsumgebung appeared first on Entwickler Konferenz.

]]>The post RAD Studio WebStencils: Die Delphi-Alternative zu Next.js & Co. appeared first on Entwickler Konferenz.

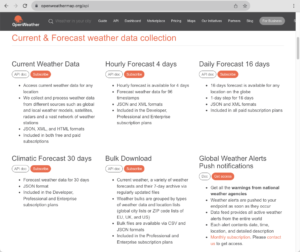

]]>In einer Zeit, in der sich Web-Entwicklungstrends ständig wandeln, erleben wir eine bemerkenswerte Rückkehr zu den Wurzeln: Server-Side Rendering (SSR) erlebt durch moderne Werkzeuge wie RAD Studio WebStencils eine Renaissance. In diesem Artikel werden Sie genau diese Technologie grundlegend kennenlernen, die Ihnen helfen wird, Ihre Webanwendungen schneller und effizienter zu entwickeln. Bevor wir in die Welt der WebStencils eintauchen, werfen wir einen Blick auf die Evolution der Web-Entwicklung und die Herausforderungen, die mit modernen Ansätzen verbunden sind. Anschließend werden die Grundlagen von WebStencils anhand

von einfachen Desktop-Anwendungen vermittelt – von der Komplexität einer Webanwendung sind wir hier noch weit entfernt. Abschließend werden wir eine simple Webseite mit Inhalten aus einer Datenbank mit WebStencils erstellen, um die Möglichkeiten dieser neuen Technologie zu demonstrieren.

Die Evolution der Web-Entwicklung

- Die Web-Entwicklung hat in den letzten Jahren einen interessanten Kreislauf durchlaufen. Während in den 2010er Jahren Client-Side Rendering mit Frameworks wie Angular und React dominierte, zeigen sich heute die Grenzen dieser Architektur:

Längere First-Paint-Zeiten: Die Zeit, bis der Benutzer etwas sieht, ist oft recht lang. - Herausforderungen bei der SEO-Optimierung: Suchmaschinen haben Schwierigkeiten, den Inhalt von SPAs zu indexieren.

- Hohe JavaScript-Bundle-Größen: Die Größe der JavaScript-Bundles kann die Ladezeiten erheblich beeinflussen. Gerade bei der Nutzung auf mobilen Geräten macht sich das schnell bemerkbar.

- Komplexe State-Management-Anforderungen: Die Verwaltung des Anwendungsstatus kann schnell unübersichtlich werden.

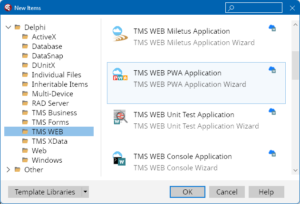

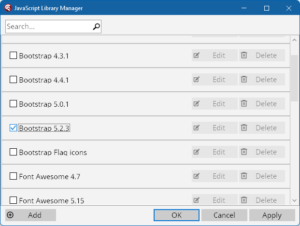

Ironischerweise gab es in den Anfangsjahren des Webs eine klare Trennung zwischen Server- und Client-Rendering. Mit der Einführung von SPAs verschwammen diese Grenzen zunehmend, was zu einer Vielzahl von Herausforderungen führte. Mit Delphi DataSnap und RAD Server wurden bereits vor vielen Jahren Lösungen für diese Probleme entwickelt. Allerdings waren diese Lösungen nicht in der Lage, die Vorteile von SSR zu nutzen. Insbesondere mit RAD Server wurden andere Ziele verfolgt. Es ging um die Entwicklung von REST-APIs und nicht um die Entwicklung von Webanwendungen. Mit RAD Studio WebStencils wird diese Lücke nun geschlossen. Zudem stellt Embarcadero mit WebStencils auch zahlreiche Beispiele für den Einsatz von HTMX auf der Client Seite bereit, die die Möglichkeiten von WebStencils eindrucksvoll demonstrieren. Ohne JavaScript-Frameworks, ohne Node.js und ohne Build-Prozesse kann so nun eine moderne Webanwendung entwickelt werden. Eine Erweiterung mit JavaScript-Frameworks ist jederzeit möglich. Selbstverständlich steht mit TypeScript auch eine typisierte Sprache im Web zur Verfügng, die immer mehr an Prägnanz gewinnt und ebenso mit WebStencils benutzt werden kann. Auch der Einsatz mit anderen Web Frameworks ist möglich. WebStencils kann z.B. auch mit TMS WEB Core genutzt werden. TMS WEB Core ist insbesondere für Delphi Entwickler interessant, da es die Entwicklung von SPAs mit Object Pascal ermöglicht und kein Erlernen einer neuen Programmiersprache erforderlich ist.

RAD Studio WebStencils: Die moderne Antwort mit einer bewährten Programmierumgebung

RAD Studio WebStencils vereint die Vorteile klassischer Server-Side Rendering-Ansätze mit modernen Entwicklungspraktiken. Das Framework ermöglicht:

- Schnellere initiale Seitenladezeiten: Es wird weniger bis gar kein JavaScript benötigt. Der Server liefert die Seite in Form von HTML und CSS direkt an den Client.

- Verbesserte Suchmaschinenoptimierung: Suchmaschinen können den Inhalt der Seite problemlos indexieren. Verschiedene Seiten werden mit unterschiedlichen URLs bereitgestellt.

- Reduzierte Client-Last: Der Client muss weniger JavaScript verarbeiten, was die Leistung auf mobilen Geräten verbessert.

- Optimierte Entwicklungszyklen: Die Entwicklung wird durch die Verwendung von Delphi und RAD Studio erheblich beschleunigt.

- Direktes Einbinden von Datenbankabfragen: Datenbankabfragen können auf dem Server direkt durchgeführt werden. Sie können bekannte Datenbankkomponenten und Frameworks in Delphi verwenden. Eine Implementierung einer REST API ist somit nicht erforderlich.

- Nutzung von CSS- und HTML-Templates: WebStencils wurden im Hinblick auf das Verwenden von CSS- und HTML-Templates entwickelt. Sie können Ihre bestehenden Templates problemlos integrieren.

- Einfache Integration von REST-APIs: REST-APIs können serverseitig integriert werden, um Daten zu laden und anzuzeigen. Selbstverständlich können Sie auch REST-APIs auf der Client-Seite verwenden.

- Unterstützung von HTMX: WebStencils wurden von Embarcadero im Hinblick auf die Verwendung mit HTMX konzipiert, um die Interaktivität der Anwendung zu erhöhen. Bei HTMX handelt es sich um eine Bibliothek, die zusätzliche HTML Attribute bereitstellt. Es ist keine Programmierung von JavaScript erforderlich. Trotzdem ermöglicht HTMX es Ihnen z.B., HTML-Elemente dynamisch zu aktualisieren, ohne die gesamte Seite neu laden zu müssen.

Der Trend zur Rückkehr zum Server-Side Rendering, auch “SSR Renaissance” genannt, zeigt sich nicht nur bei WebStencils. Frameworks wie Next.js, Remix und Nuxt.js folgen einem ähnlichen Ansatz. Dies unterstreicht die wachsende Erkenntnis, dass ein hybrider Ansatz aus Server- und Client-Rendering oft die beste Lösung darstellt.

Diese Evolution markiert einen wichtigen Wendepunkt in der Web-Entwicklung, bei dem RAD Studio Web-Stencils eine Schlüsselrolle einnimmt.

Und was passiert mit den Single Page Applications und dazugehörigen Frameworks?

WebStencils haben nicht das Ziel verfolgt, Single Page Applications (SPAs) zu ersetzen, sondern um sie zu ergänzen. WebStencils können problemlos in bestehende SPAs integriert werden. Sie können sie verwenden, um bestimmte Teile Ihrer Anwendung serverseitig zu rendern, während andere Teile weiterhin als SPAs funktionieren. Somit können Sie die Vorteile beider Ansätze nutzen

und ihr gewohntes Web Framework, wie z.B. TMS WEB Core, weiterhin verwenden.

In vielen Fällen ist eine hybride Lösung die beste Wahl. WebStencils ermöglicht es Entwicklern, die Vorteile beider Ansätze zu nutzen und maßgeschneiderte Lösungen für ihre spezifischen Anforderungen zu erstellen. Insbesondere in TMS WEB Core führt die Kombination von SSR und SPAs zu einer kürzeren und effizienteren Entwicklungszeit.

Loslegen mit WebStencils

RAD Studio WebStencils sind Bestandteil von RAD Studio bzw. Delphi 12 und erfordern keine besondere Installation. Erst kürzlich wurde Version 12.3 von RAD Studio vorgestellt, die auch neue Funktionen für WebStencils mitbringt. Sie können nach der Installation sofort loslegen und die Vorteile von Server-Side Rendering in Ihren Projekten nutzen. Embarcadero stellt leider nur wenige Beispiele zur Verfügung. Hier sei auf die zahlreichen Webinare von Embarcadero verwiesen, die auch nachträglich noch auf YouTube

angeschaut werden können. WebStencils wurden hier in den vergangenen Monaten thematisiert und mit zahlreichen Beispielen demonstriert.

Wie funktionieren WebStencils?

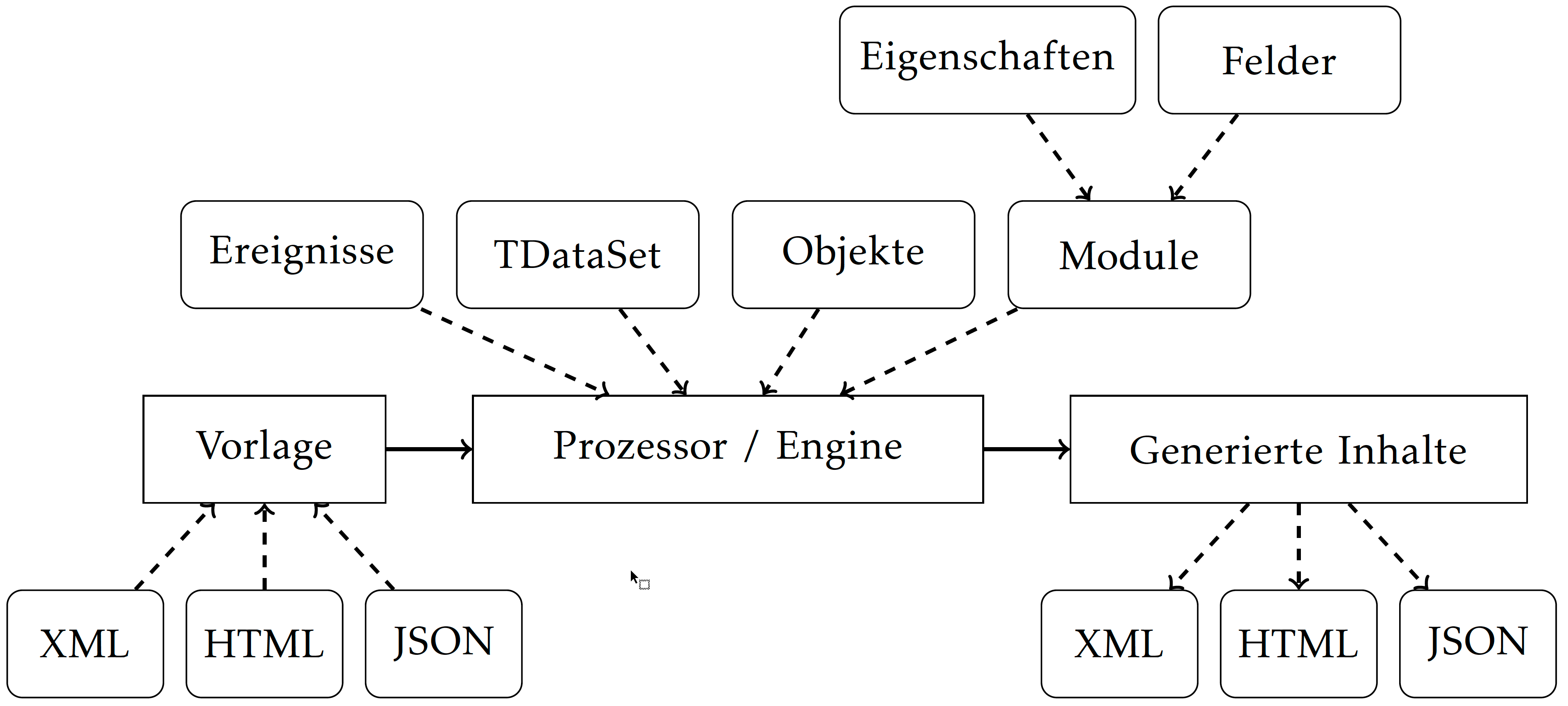

Im Kern erzeugt WebStencils Textinhalte basierend auf einer Vorlage. Sie können diese Vorlagen entweder als String definieren oder aus einer Datei laden. Es gibt keine zwingende Verbindung zu Webtechnologien. WebStencils kann in jedem Delphi-Projekt verwendet werden. Laut Marco Cantu, dem Produktmanager von Delphi, ist es von Natur aus kein meinungsstarkes (engl. opinionated) Framework. Dies öffnet es für die Verwendung in jedem Szenario und ermöglicht es auch Drittentwicklern, es in ihren eigenen Frameworks zu verwenden. Embarcadero hat daher alle Komponenten für WebStencils aus Klassen abgeleitet, die leicht mit WebBroker, DataSnap und RAD Server verwendet werden können. Dies impliziert auch den Hauptanwendungsfall für WebStencils: Einfache Erstellung von Webseiten oder anderen web-spezifischen Dateiformaten mit einer modernen Template-Engine. Die folgende Abbildung zeigt die drei Bausteine von WebStencils. Eine Vorlage wird in den Prozessor geladen, der an eine Engine gebunden werden kann. Sowohl für Prozessor (Processor) als auch Engine existieren Komponenten, die man einfach auf Formularen und Datenmodulen verwenden kann. Eine Engine kann dbaei mehrere Prozessoren mit gemeinsamen Einstellungen verwalten, ist jedoch völlig optional und kein zwingender Bestandteil der Prozesskette. Die folgenden Beispiele werden sich daher auf die Verwendung des Prozessors (Processor) beschränken. Jedes Textformat kann generiert werden. Heutzutage sind XML, HTML, JSON und Markdown wahrscheinlich die am häufigsten verwendeten Dateiformate. Wir erkennen nun direkt, dass es keinerlei Bindung an die exklusive Verwendung für Webanwendungen gibt. Es ist somit z.B. auch denkbar WebStencils für die Ertstellung von simplen ‘Serienbriefen’ in VCL Desktopanwendungen zu verwenden.

Der Prozessor erzeugt Inhalte basierend auf einer Vorlage. Eine Vorlage enthält Platzhalter, die

durch Text ersetzt werden können. Dieser Text kann durch Ereignisse, eine TDataSet-Instanz oder

Felder und Eigenschaften eines beliebigen Objekts (abgeleitet von TObject) bereitgestellt werden.

Der Prozessor akzeptiert eine einzelne Objektinstanz sowie ein Modul, das seine Eigenschaften

und Felder mithilfe eines benutzerdefinierten Attributs an den Prozessor veröffentlicht.

Zusätzlich zum Textersatz kann die Vorlage spezielle Schlüsselwörter enthalten. Das sind z.B. Aus-

drücke um simple Berechnungen durchzuführen sowie Bedingungen (@if), ob Teile der Vorlage einbezogen werden sollen oder nicht. Außerdem können Sie über alle Datensätze eines Datensets iterieren und bestimmte Passagen der Vorlage für jeden Datensatz generieren (@foreach).

Wenn Sie eine Vorlage angeben, kann sie spezielle Platzhalter enthalten, um Teile aus anderen Vorlagen zu laden bzw. importieren. Auf diese Weise können Sie leicht ein gemeinsames HTML-Dokument definieren und dann individuell mit dem Inhalt für den jeweiligen zu generierenden Inhalt füllen.

Figure 1: So funktionieren WebStencils

Figure 1: So funktionieren WebStencils

Stellen Sie sich eine Website vor, die in drei Hauptgruppen strukturiert ist: – Kopfzeile (Header) mit Navigationsleiste – Hauptinhalt (Main Content) – Fußzeile (Footer)

Sie können dann eine Vorlagendatei angeben, die die Kopf- und Fußzeile enthält, aber der Hauptinhalt wird jedes Mal ersetzt.

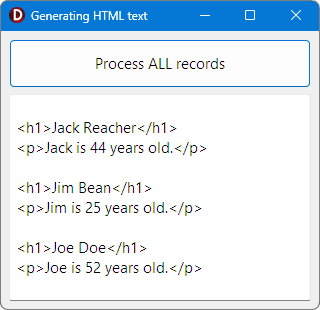

Die folgenden Beispiele führen in die Grundlagen der Vorlagenerstellung ein und zeigen, wie man Vorlagenplatzhalter mit Werten durch Ereignisse, Datasets und Objekte ersetzt. Weiterführende Beispiele verwenden die Edge-Webbrowser-Komponente, um responsive Webinhalte darzustellen. Die Vorlagen enthalten dann HTML, das mit Daten aus einer SQLite-Datenbank gefüllt wird. Eine Erstellung von Web Servern mit Web Broker ist ebenfalls möglich, wird aber in diesem Artikel nicht behandelt.

Formale Beschreibung von WebStencils

WebStencils ist ein ‘Textinhalt-Generator’, der für serverseitiges Scripting verwendet werden kann. Im Kontext von mehrschichtigen Anwendungen ermöglicht die Skriptsprache innerhalb einer Vorlage die Erstellung beliebiger Textformate im Backend. Die Tatsache, dass Sie sowohl HTML als auch JSON erstellen können, macht es sehr flexibel, sowohl eine API als auch sogenannte visuelle Serverkomponenten zu implementieren. Sie können die Stärke der Delphi-Datenbank-Frameworks nutzen, um Informationen aus Datenbanken einzubeziehen, aber auch Ihre Datenbanken mit Daten zu aktualisieren, die im Frontend eingegeben wurden. Es ist

jedoch nicht nur für mehrschichtige Szenarien geeignet. WebStencils kann auch in herkömmlichen Delphi Windows Desktop-Anwendungen verwendet werden, um Serienbriefe oder andere dynamische Textdokumente zu erstellen. Für Web-Anwendungsfälle kann es leicht in bestehende Web-Frameworks wie z.B. WebBroker, RAD Server, DataSnap und TMS WEB Core integriert werden, um die Erstellung von HTML-Seiten zu unterstützen, die auf Vorlagen basieren.

Hallo WebStencils!

Lassen Sie uns WebStencils mit einem sehr einfachen Beispiel kennenlernen. Es kann als das ‘Hello World’ von WebStencils bezeichnet werden. Ich habe eine Windows VCL-Anwendung erstellt. Das Web wird in diesem Beispiel noch keine Rolle spielen. Zuerst müssen wir verstehen, wie WebStencils funktionieren, und dann können wir dies auf Webtechnologien übertragen.

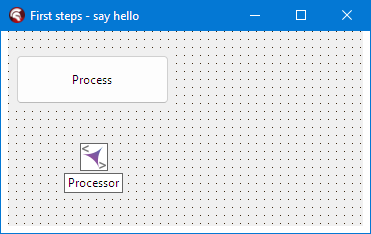

Das Hauptformular der Anwendung enthält eine einzelne Schaltfläche, um den WebStencils-Prozessor zu starten. Der Prozessor kann in der Werkzeugpalette als TWebStencilsProcessor gefunden werden.

Figure 2: Hauptformular des Beispiels im Formulardesigner.

Offensichtlich sehen wir zur Laufzeit nur die einzelne Schaltfläche. Innerhalb des Schaltflächenereignisses werden wir den Code implementieren, um WebStencils zu verwenden. Wenn Sie auf die Schaltfläche klicken, wird nur ein kurzes Nachrichtenfeld mit dem Text –Hello World– angezeigt.

Figure 3: Hauptformular des Beispiels im Formulardesigner.

Der WebStencils Prozessor benötigt eine Vorlage und mindestens ein Objekt, ein Dataset, ein Modul oder ein Ereignis, um auf die Vorlage angewendet zu werden.

Diese schließen sich nicht gegenseitig aus. Sie können gleichzeitig beliebige Eingabequellen anwenden. Das bedeutet, dass Sie einige Ersetzungen in Ihrer Vorlage sowohl mit einem Ereignis als auch mit einem Dataset bereitstellen können, zum Beispiel.

In diesem Beispiel werden wir ein Ereignis bereitstellen, das Text innerhalb der Vorlage ersetzt.

Eine Vorlage definieren

Eine Vorlage ist nichts anderes als reiner Text. Sie kann entweder als TStringList in der Eigenschaft InputLines oder als Dateiname angegeben werden. Die Datei wird dann geladen, bevor der Prozessor aufgefordert wird, die Vorlage zu verarbeiten.

Wenn Sie einen Dateinamen angeben, wird jeder andere Vorlageninhalt ignoriert. Nur der Inhalt der angegebenen Datei wird verwendet. Jeder Text im Inhalt bleibt unberührt und wird in die Ausgabe kopiert, es sei denn, Sie verwenden das @-Symbol. Dieses Symbol zeigt WebStencils an, dass Sie entweder eine zu ersetzende Variable oder ein Schlüsselwort definieren möchten. Schlüsselwörter sind zum Beispiel @if oder @foreach und werden später besprochen.

Konzentrieren wir uns darauf, Text innerhalb der Vorlage zu ersetzen.

Processor.InputLines.Text := ’–@Data.Text–’;

Die obige Zeile setzt die Vorlage innerhalb der Processor-Komponente. Die Eigenschaft InputLines ist vom Typ TStringList. Wie bereits erläutert, ist dies eine Alternative zur Angabe eines Pfads zu einer Datei, die die Vorlage enthält. Wir bemerken, dass die Vorlage das @-Symbol gefolgt von Data.Text verwendet. Data wird als Objekt und Text als Eigenschaft bezeichnet. Formal werden diese beiden vom Prozessor ausgewertet und ergeben einen Wert.

Das Objekt und die Eigenschaft sind beide symbolische lokale Namen und können mithilfe des OnValue-Ereignishandlers aufgelöst werden. Alternativ können wir Objekte, Datensätze und Module unter einem ‘Namen’ registrieren, den wir dann mit @ referenzieren können. Der resultierende Wert ist dann entweder eine Zeichenkette, die im OnValue-Ereignis übereinstimmt, eine Objekteigenschaft oder ein Feld eines Datasets.

Da wir in diesem Beispiel einen einfachen Ereignishandler verwenden möchten und keine Datensätze oder Objekte definiert haben, müssen wir ein OnValue-Ereignis für die Processor Komponente implementieren.

Schwierige Verwendung von @

Auf den ersten Blick erscheint alles ziemlich einfach zu sein. Wann immer Sie einen Marker definieren möchten, verwenden Sie das @-Symbol. Es gibt nur ein winziges Problem. Was ist, wenn Ihre Vorlage @-Symbole enthält? Es gibt mehrere Fälle, in denen dies passieren kann:

- Ihre Vorlage enthält eine E-Mail-Adresse: [email protected]

- Sie möchten einen X (Twitter)-Feed referenzieren: @hflickster

- Sie verwenden eine HTML-Vorlage, die CSS-Referenzen mit Versionsnummern enthält:

<link href=”[email protected]/dist/css/bootstrap.min.css”> - CSS-Animationsdefinitionen, die @keyframe verwenden.

Dies sind nur einige Beispiele, die mir in den letzten Monaten begegnet sind. Ich bin sicher, es gibt noch viele mehr.

Die Lösung besteht darin, ein zusätzliches @-Symbol hinzuzufügen. Wenn Sie das @-Symbol tatsächlich Teil Ihrer Vorlage machen möchten, müssen Sie zwei davon in Ihre Vorlage aufnehmen. Das bedeutet, wenn Sie @@ schreiben, wird es nach der Verarbeitung zu @. Angenommen, ich möchte meine E-Mail-Adresse in die Vorlage aufnehmen, würde ich die folgende Vorlagenzeichenkette

erstellen:

Email me at holger@@flixengineering.com !

Dies wird zu:

Email me at [email protected] !

Dies kann sehr mühsam sein, insbesondere wenn Sie Dateien von der Festplatte laden, die für andere Zwecke als die Verwendung mit der WebStencil-Vorlagen-Engine vorbereitet wurden. Stellen Sie sich vor, Sie greifen auf ein Repository von HTML-Vorlagen in Ihrem Unternehmen zu, das auch von anderen HTML-Anwendungen verwendet wird. Sie können diese Vorlagen nicht ändern, ohne es den anderen Anwendungen unmöglich zu machen, sie zu verwenden. Daher müssten Sie diese Vorlagen laden, die Änderungen vornehmen und sie dann an WebStencils übergeben. Obwohl dies möglich ist, ist es eine sehr unbefriedigende Lösung. Stattdessen hat WebStencils das @processing-Schlüsselwort eingeführt: – @processing on: Verarbeite Marker in dieser Vorlage. Dies ist die Standardeinstellung. – @processing off: Verarbeite Marker in dieser Vorlage nicht. Dies ermöglicht es, Vorlagen ‘wie sie sind’ an den Prozessor zu übergeben.

Das @processing-Schlüsselwort betrifft die gesamte Vorlage. Daher ist es ratsam, es in Verbindung mit kleineren Vorlagenschnipseln zu verwenden, die Sie mithilfe von @import in eine größere Vorlage laden.

Auf diese Weise kann jeder Schnipsel individuell Marker verarbeiten oder nicht.

Implementierung des Ereignisses

Wenn wir die Prozessor-Komponente auswählen und uns ihre Ereignisse ansehen, finden wir das Ereignis namens OnValue.

procedure TForm1.ProcessorValue(Sender: TObject; const AObjectName, APropName:

string; var AReplaceText: string; var AHandled: Boolean);

begin

if (AObjectName = ’Data’) and (APropName = ’Text’) then

begin

AReplaceText := ’Hello World’;

AHandled := True;

end;

end;

Wann immer der Prozessor auf ein @-Symbol gefolgt von einem Objekt und einem Wert stößt, wird OnValue ausgelöst. Im Parameter AObjectName wird der Name des Objekts sowie der Name des Werts in APropName übergeben. Der Codeausschnitt zeigt, dass wir einfach den Namen des Objekts und den Eigenschaftsnamen vergleichen können, ob sie mit dem übereinstimmen, wonach wir

suchen. In diesem Fall möchten wir Data.Text durch Hello World für das Objekt Data und seine Eigenschaft Text ersetzen. Dafür weisen wir den Ersetzungstext der Variablen AReplaceText zu. Diese wird an den Prozessor zurückgegeben, da sie mit var definiert ist. Gleiches gilt für den Parameter AHandled. Sie müssen ihn auf True setzen, wenn Sie eine Ersetzung vorgenommen haben. Auf diese Weise weiß der Prozessor, ob alle Symbolmarkierungen in der Vorlage ersetzt wurden oder nicht. Wenn nicht alle Markierungen behandelt werden, kann der Prozessor eine Exception werfen.

Starten des Prozessors

Um den Prozessor zu starten, lesen Sie den generierten Text mit der Content-Funktion. Es sieht aus wie eine Eigenschaft, ist aber tatsächlich eine Funktion:

TWebStencilsProcessor = class(TCustomContentProducer, IWebStencilsComponent)

public

constructor Create(Owner: TComponent); override;

destructor Destroy; override;

/// <summary> Produziert Inhalt aus der Vorlage, die durch InputFileName angegeben wird.

/// Wenn InputFileName leer ist, wird InputLines verwendet. </summary>

function Content: string; override;

Die vollständige Implementierung des Button.OnClick-Ereignisses ist wie folgt:

procedure TForm1.Button1Click(Sender: TObject);

begin

Processor.InputLines.Text := ‘–@Data.Text–‘;

ShowMessage(Processor.Content);

end;

Weisen Sie zuerst die Vorlage mit einem String zu. Zeigen Sie dann den generierten Inhalt mit ShowMessage an. Es wird das OnValue-Ereignis bei Bedarf implizit abgerufen. In diesem Fall wird es nur einmal ausgeführt, da wir nur einen Marker verwenden.

Es ist nicht notwendig, Leerzeichen zwischen Markern und dem Text, der Teil der Vorlage ist, zu lassen. Ich habe absichtlich führende und nachfolgende — Zeichen zur Vorlage hinzugefügt. Nur die Markerdeklaration wird ersetzt. Denken Sie auch daran, dass jedes Mal, wenn Sie Processer.Content lesen, die Vorlage erneut ausgewertet wird. Das bedeutet, dass Sie dieselbe Komponente für verschiedene Vorlagen oder flexiblere Ereignisimplementierungen wiederverwenden können.

Ja, es ist so einfach!

Herzlichen Glückwunsch! Dies sind die Grundlagen der Prozessor-Engine von WebStencils. Sie hätten nicht gedacht, dass es so einfach sein würde, oder?

Auf diese Weise können Sie bereits flexible Textinhalte erstellen, die sich beispielsweise auf berechnete Werte stützen.

Das Ersetzen aller Platzhalter im OnValue-Ereignis könnte für alle möglichen Ersetzungen verwendet werden, ist jedoch nicht sehr effizient. Stellen Sie sich vor, ein Dataset hat Dutzende von Feldern und Sie müssen für jedes Feld mehrere Codezeilen im Ereignishandler hinzufügen.

WebStencils bietet Mittel, um dies viel sauberer und effizienter zu handhaben. Daher zeigt das nächste Beispiel, wie man Datensätze aus einem TDataSetverwendet.

Verarbeitung von einzelnen Datensätzen und kompletten Datasets

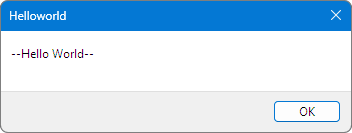

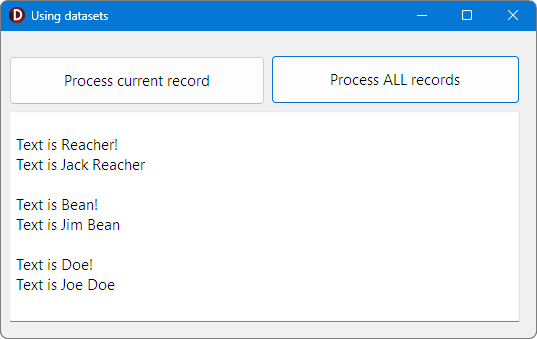

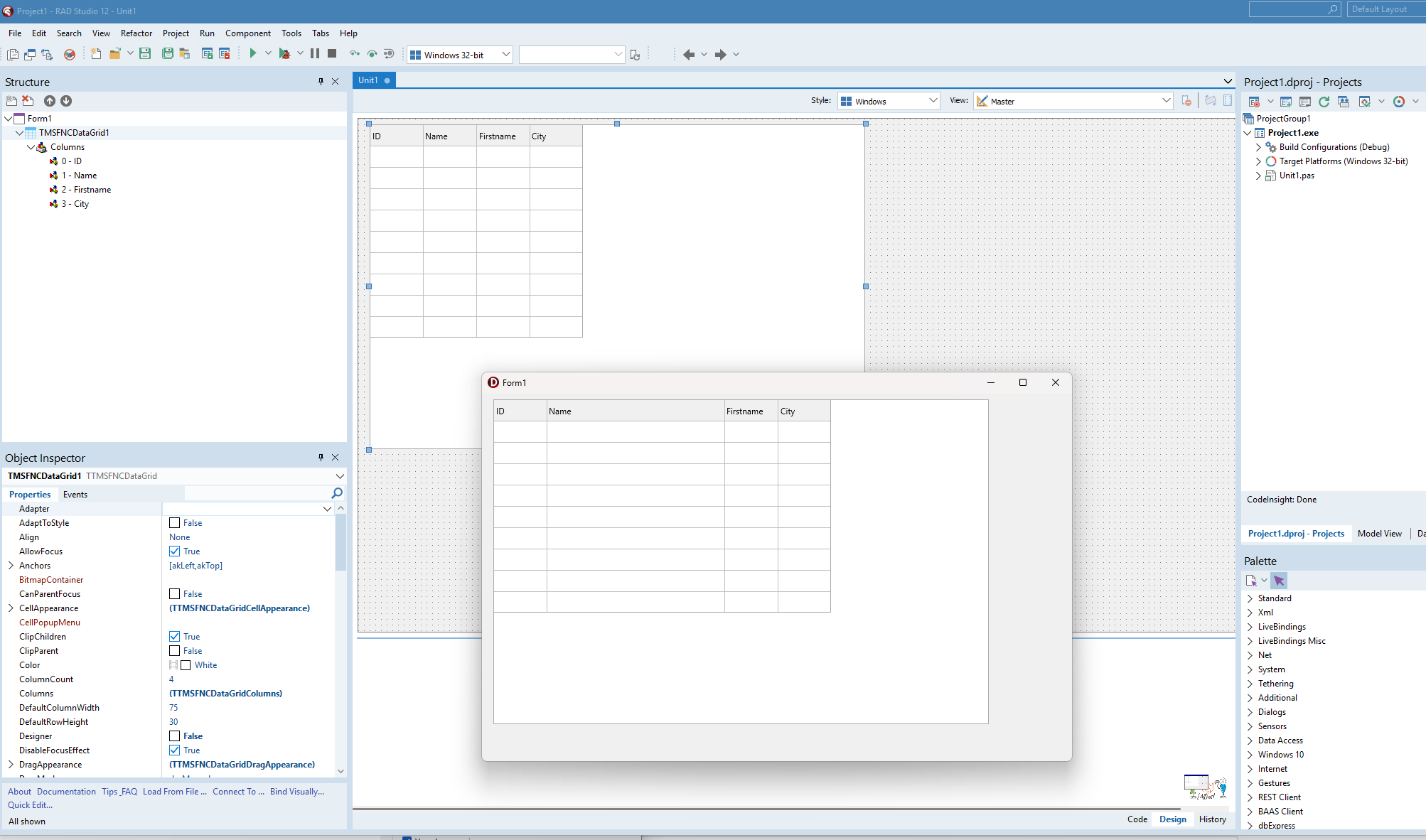

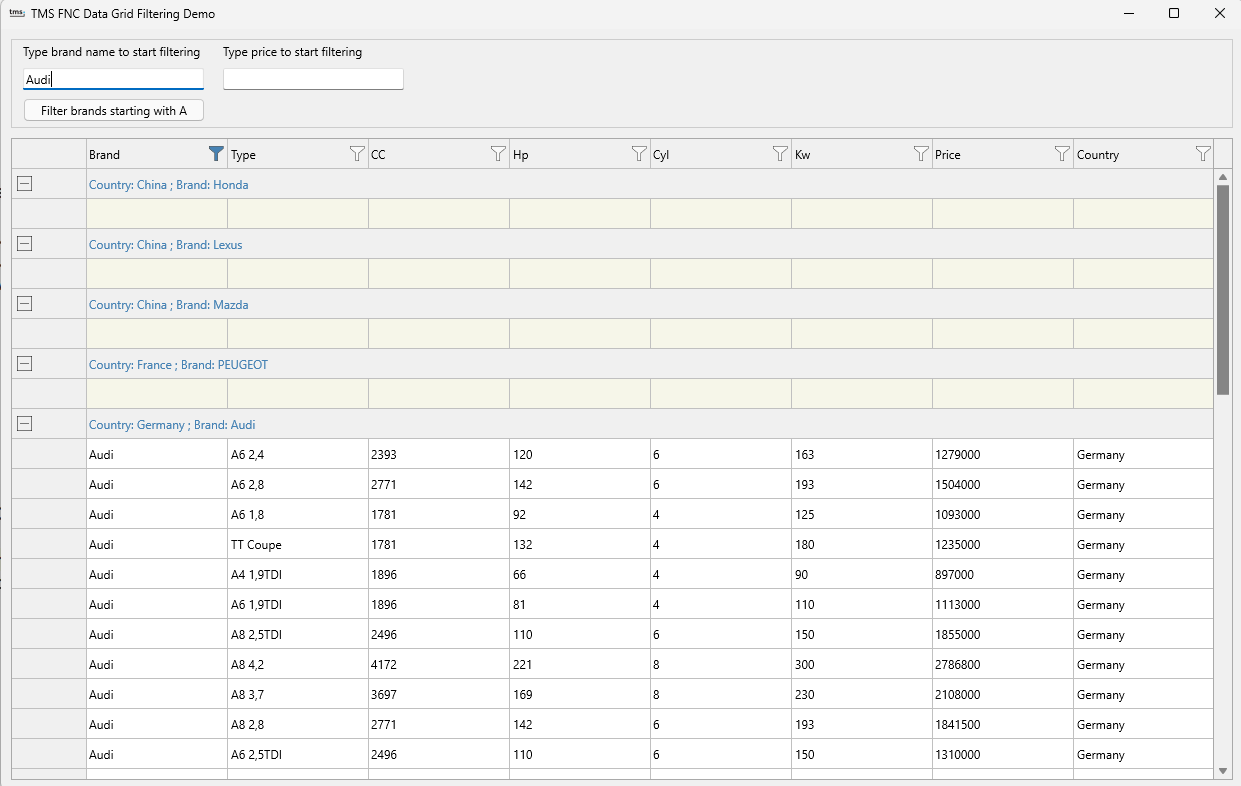

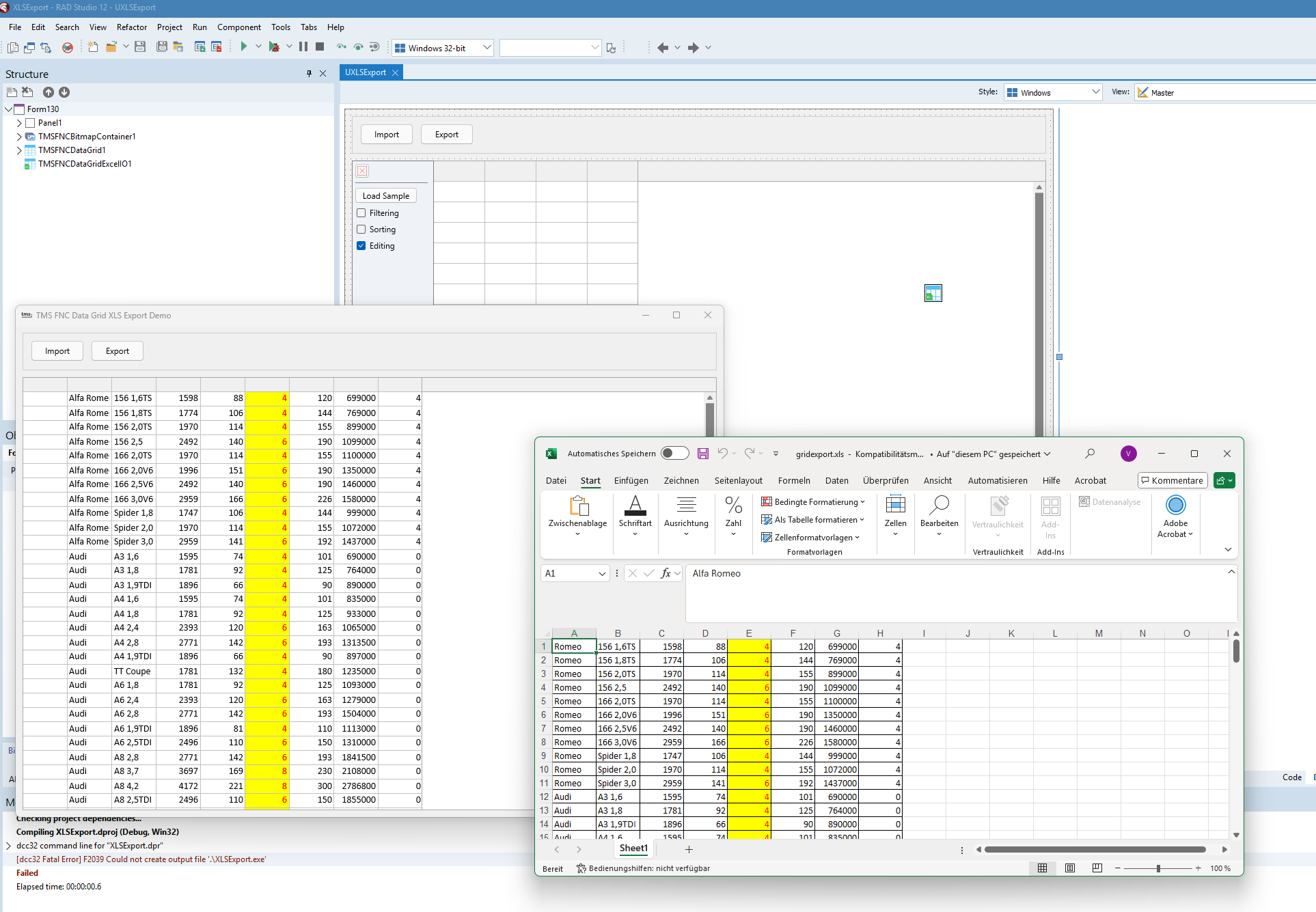

Im ersten Beispiel haben wir gelernt, wie man einen Platzhalter in einer Vorlage mit dem OnValue-Ereignis ersetzt. Jetzt wird es etwas komplexer, da wir Datasets mit WebStencils einführen. Auch hier verwenden wir eine Windows VCL-Anwendung, um die Funktion zu demonstrieren. Zur Entwurfszeit platzieren wir zwei Schaltflächen auf dem Formular. Eine Schaltfläche wird ein Beispiel ausführen, dass eine Vorlage verwendet, um den aktuellen Datensatz des Datasets zu verarbeiten (Process current record). Die andere Schaltfläche startet ein Beispiel, das eine Vorlage erstellt, um das gesamte Dataset zu durchlaufen (Process ALL records). Der vom Prozessor generierte Text wird im Memo-Steuerelement namens txtResult angezeigt.

Figure 4: Hauptformular des Beispiels im Formulardesigner.

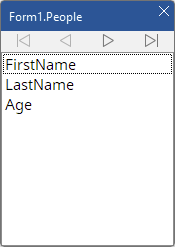

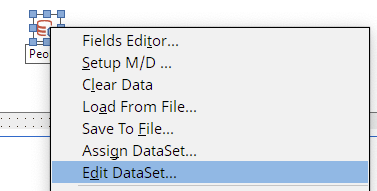

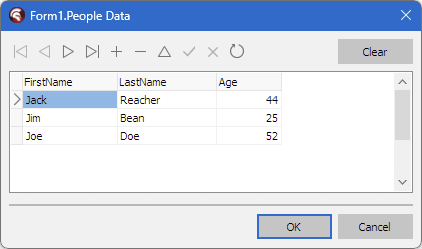

Die Daten werden in einem TFDMemTable gespeichert. Dies ist die FireDAC-Komponente, die ein Client Dataset mit vielen weiteren Funktionen als die traditionelle TCientDataset-Komponente kapselt. Die in diesem Dataset definierten Daten sind trivial. Wenn Sie den Feldeeditor öffnen, sehen Sie, dass es drei Felder mit primitiven Datentypen gibt.

Wir können den Vor- und Nachnamen einer Person sowie ihr Alter speichern. Die ersten beiden Felder sind natürlich vom Typ String, das letzte Feld ist ein Integer-Feld. Eine der großartigen Funktionen von FireDAC ist, dass Sie die Daten dieser Datensätze zur Entwurfszeit im Formular-Editor bearbeiten können. Klicken Sie einfach mit der rechten Maustaste auf die TFDMemTable-Komponente und wählen Sie Edit DataSet… aus, um den Entwurfszeit-Dateneditor zu öffnen.

Figure 5: Feld-Editor des FDMemTable

Figure 6: Daten können direkt zur Entwurfszeit bearbeitet werden.

Figure 7: Der Entwurfszeit-Dateneditor von FireDAC

Die Daten werden innerhalb des Formulars gespeichert und sind zur Laufzeit verfügbar. Dies macht das Erstellen von Demos mit FireDAC zu einer Freude, da Sie für einfache Beispiele wie dieses keine Datenbankdatei benötigen. Wenn Sie die Anwendung ausführen, können Sie entweder den aktuellen Datensatz (der der erste sein wird) oder alle Datensätze verarbeiten. Wenn Sie möchten, können Sie dieses Demo erweitern, indem Sie ein Navigator-Steuerelement hinzufügen, um durch das Datenset zu navigieren.

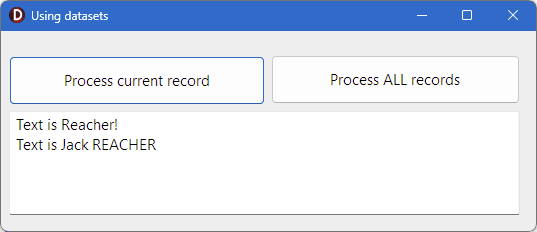

Zugriff auf den aktuellen Datensatz

Um auf einen Datensatz zuzugreifen, können Sie die Methode verwenden, die Sie im ersten Beispiel gelernt haben. Sie binden das Dataset an einen Objektnamen, und die Feldnamen werden als Werte verwendet. Schauen wir uns die verwendete Vorlage an:

procedure TForm1.btnProcessOneClick(Sender: TObject);

begin

Processor.InputLines.Text :=

”’

Text is @People.LastName!

Text is @People.FirstName @(UpperCase(People.LastName))

”’;

Process;

end;

Erneut weisen wir InputLines.Text einen String zu. Die erste Zeile der Vorlage bezieht sich auf People.LastName. Der Wert von People bezieht sich auf das Feld LastName. Wie können wir WebStencils mitteilen, People an das Dataset zu binden? Die Prozessorkomponente Processor hat eine Methode namens AddVar, die drei Parameter akzeptiert:

- Einen Namen für das zu bindende Objekt.

- Eine Objektreferenz auf ein Dataset.

- Einen Boolean-Wert, ob diese Objektreferenz nach der Verarbeitung aus dem Speicher freigegeben werden soll.

Im Code sieht das so aus:

Processor.AddVar( ’People’, People, False );

Das bedeutet, wir binden das Dataset People an den Marker namens People. Beachten Sie, dass der Markername ein String ist. Der letzte Parameter ist False, da die VCL People freigibt, wenn die Anwendung beendet wird. Wenn Sie True angeben würden, würde das Dataset nach der Verarbeitung freigegeben, und Sie würden höchstwahrscheinlich eine Zugriffsverletzung erhalten, wenn die Anwendung beendet wird. Wenn Sie den Prozessor ein zweites Mal ausführen, wird er mit Sicherheit eine Zugriffsverletzung auslösen, da das Dataset nicht mehr verfügbar ist.

Zusammenfassend weist die Zeile das Dataset People allen @People-Vorkommen zu. Dies impliziert auch, dass jeder Wert ein Feld im Dataset sein muss. Betrachtet man @People.LastName, ist dies korrekt, und wir erwarten, dass der Nachname anstelle des Markers eingefügt wird, wenn er verarbeitet wird.

Die nächste Zeile der Vorlage fügt ebenfalls den Vornamen mit @People.FirstName ein. Anschließend wird die nächste Ersetzung etwas komplexer, zeigt jedoch, dass wir sogar Funktionen aus Delphi in unserer Vorlage verwenden können. WebStencils ist ziemlich intelligent und löst Funktionen mithilfe von RTTI auf.

Falls Sie nicht wissen, was RTTI ist, denken Sie einfach so darüber: Sie können Funktionsnamen eingeben, die für die Prozessorkomponente zugänglich sind, und dieser wird in der Lage sein, diese Funktionen aufzurufen.

Wenn Sie einen Ausdruck auswerten möchten, müssen Sie ihn in Klammern setzen. Anstelle von @People.LastName müssen Sie also @( Ausdruck ) verwenden. Die Klammern sind der Schlüssel, damit es funktioniert. So wird @( UpperCase( @People.LastName )) zuerst @People.LastName auswerten und das Ergebnis dann in UpperCase einfügen. Beachten Sie jedoch, dass Sie keine String-Helfer oder andere Dinge mit Duck Typing aufrufen können. Dies wird nicht funktionieren:

@People.LastName.toUpper

Das würde buchstäblich zu folgendem Ergebnis führen, wenn der Nachname des Datensatzes auf Reacher gesetzt ist:

Reacher.toUpper

Der .toUpper-Teil wird einfach zu Text und nicht zu einem Ausdruck. Außerdem ist es ratsam, Ausdrücke sehr kurz zu halten. Verwenden Sie berechnete Felder, wann immer Sie Datensätze mit WebStencils verwenden. Ihr Code wird dadurch viel sauberer, und Sie haben Zugriff auf die gesamte Vielfalt der Object Pascal-Sprache. Genau wie im ersten Beispiel ist dies bereits alles, was Sie tun müssen, um einen einzelnen Datensatz zu verarbeiten:

- Legen Sie die Vorlage fest.

- Verknüpfen Sie Marker mit einem Dataset.

- Führen Sie den Prozessor aus.

- Geben Sie das Ergebnis aus.

Beachten Sie, dass Sie den zweiten Schritt nur einmal implementieren müssen und die Vorlage so oft ändern können, wie Sie möchten. Die Referenz des Namens zum Dataset bleibt erhalten. Wir nutzen dies im Beispiel, da ich das Symbolmarker nur einmal für beide Anwendungsfälle binde, nachdem das Formular erstellt wurde:

procedure TForm1.FormCreate(Sender: TObject);

begin

txtResult.Clear;

Processor.AddVar( ‘People’, People, False );

end;

Wie zuvor gezeigt, weisen wir im Button-Klick-Ereignis die Vorlage zu und führen den Prozessor aus, indem wir die Methode Process aufrufen. Die Methode Process weist den Inhalt der Memo-Komponente zu. Implizit wird dadurch die Vorlage verarbeitet.

procedure TForm1.Process;

begin

txtResult.Lines.Text := Processor.Content;

end;

Figure 8: Ausgabe des Beispiels für einen Datensatz

Iterieren aller Datensätze

Wenn wir alle Datensätze iterieren und eine Vorlage darauf anwenden möchten, müssen wir die Vorlage ändern und nicht wie man vielleicht denken könnte die Art und Weise, wie wir den Prozessor aufrufen. Genauer gesagt, kommt hier das Schlüsselwort @foreach ins Spiel. Wir werden zunächst die vereinfachte Variante des Schlüsselworts verwenden, bevor wir uns die formal korrekte und bessere Methode ansehen, eine Iteration in der WebStencils-Skriptsprache auszudrücken. Das Schlüsselwort @foreach funktioniert ähnlich wie Delphis relativ neue for-in-Schleife. Denken Sie an die Delphi-Schleife for var person in people. Wenn people eine Liste ist, iterieren wir die Liste, und jedes Element der Liste wird in person zurückgegeben. Genau so funktioniert @foreach. Der Name leitet sich tatsächlich von anderen Programmiersprachen ab, die keine for-in-Schleife, sondern ein foreach-Schlüsselwort haben. Schauen wir uns die Vorlage an, die wir verwenden können, um alle Datensätze in einem Dataset zu iterieren. Wie zuvor ist das Dataset an den Marker namens People gebunden.

procedure TForm1.btnProcessAllClick(Sender: TObject);

begin

Processor.InputLines.Text := ”’

@ForEach People {

Text is @loop.LastName!

Text is @loop.FirstName @loop.LastName

}

”’;

Process;

end;

Das Schlüsselwort @foreach wird gefolgt vom Namen des Markers, der auf das Dataset verweist. In diesem Fall verwenden wir erneut People. Dann müssen wir den Teil der Vorlage, der für jeden Datensatz eingefügt werden soll, mit {…} umschließen. Betrachtet man das Beispiel, bedeutet das, dass der folgende Teil für jeden Datensatz eingefügt wird:

Text is @loop.LastName!

Text is @loop.FirstName @loop.LastName

Die Referenz wechselt von People zu @loop. Sie bezieht sich auf die aktuelle Instanz der Iteration. Wie zuvor können wir nun die Feldnamen als Werte verwenden. Somit bezieht sich @loop.LastName auf das Feld LastName des aktuellen Datensatzes des Iterationsschritts. WebStencils stellt sicher, dass es mit dem ersten Datensatz loslegt und mit dem letzten endet. Sie müssen nicht First aufrufen, um den Datensatzzeiger auf den ersten Datensatz zu setzen. WebStencils wird den Datensatzzeiger vor der Verarbeitung auf den ersten Datensatz setzen.

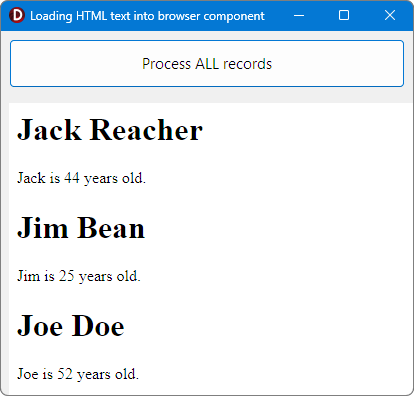

Bei Anwendung der Vorlage auf alle Datensätze wird der Text in der Memo-Komponente wie folgt angezeigt:

Erweiterte Nutzung von @ForEach

Das letzte Beispiel verwendet @ForEach, um über alle Datensätze eines Datasets zu iterieren. Jedes Element der Iteration kann mit @loop angesprochen werden. Dies ermöglicht es uns, über eine Liste zu iterieren. Sobald jedoch verschachtelte Schleifen benötigt werden, ist es nicht mehr möglich, auf das aktuelle Element einer der Schleifen zuzugreifen, weil beide Schleifen dann über @loop referenziert werden. Das bedeutet, dass Sie nicht mehr wissen, auf welches Element Sie sich beziehen. In diesem Fall müssen Sie die vollständige Definition von @ForEach verwenden.

Genauer gesagt ist @ForEach Object {} eine vereinfachte Syntax, die von WebStencils aus Komfortgründen bereitgestellt wird. Die vollständige Definition von @ForEach sieht etwas komplexer aus:

@ForEach ( var Object in List ) { … }

Das bedeutet, dass unser letztes Beispiel auch wie folgt ausgedrückt werden könnte:

Figure 9: Ausgabe des Beispiels für alle Datensätze

@ForEach ( var loop in People ) { … }

Angenommen, jeder Datensatz in People hätte mehrere Adressen. Sie könnten wie folgt iterieren:

@ForEach ( var person in People ) {

@ForEach ( var address in @person.addresses ) {

Text ist @address.street

Text ist @address.city

}

}